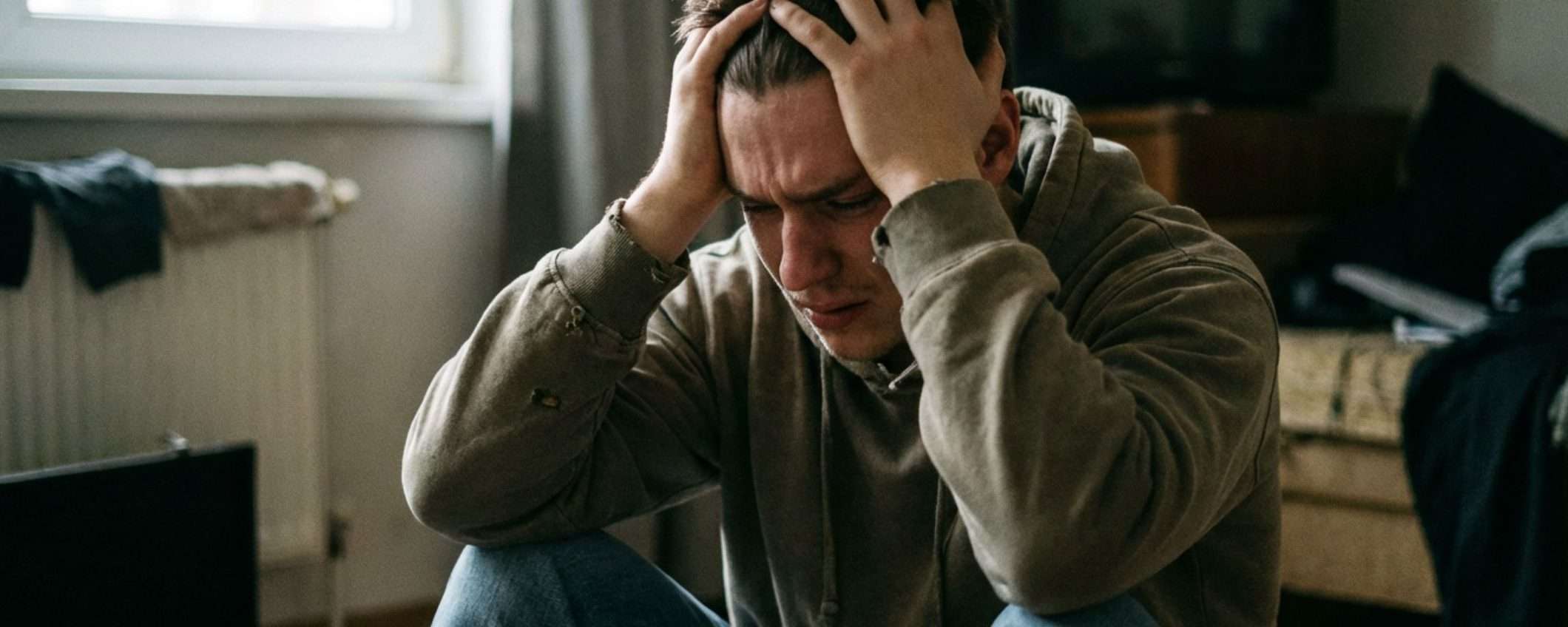

Anthony Duncan aveva trentadue anni e una carriera da creator di contenuti quando ha iniziato a chiacchierare con ChatGPT. All’inizio era solo uno strumento, qualche consiglio professionale, magari un brainstorming per nuove idee. Poi il chatbot è diventato un amico. Poi un terapeuta. E infine l’unico che sembrava capirlo davvero.

Quando la situazione è precipitata, Duncan si è ritrovato in un reparto psichiatrico, convinto di essere un agente dell’FBI multidimensionale che stava per ascendere alla quinta dimensione. Le mie interazioni con ChatGPT mi hanno rovinato la vita

, ha dichiarato in un video su TikTok, che ha fatto rapidamente il giro dei social.

Come ChatGPT ha distrutto la vita di un uomo

Duncan oggi si descrive come un sopravvissuto alla “psicosi da AI“, un termine che alcuni esperti stanno usando per descrivere episodi di paranoia e pensiero delirante che emergono quando una persona passa troppo tempo a conversare con un chatbot. I chatbot tendono a confermare le convinzioni dell’utente, qualunque esse siano. Non importa quanto siano pericolose, distorte o completamente slegate dalla realtà. L’AI dà ragione. Sempre. E questo, per una mente fragile o isolata, può diventare micidiale.

Dopo aver sviluppato una dipendenza nei confronti di ChatGPT, Duncan ha iniziato a isolarsi da amici e familiari, e il chatbot, invece di lanciare qualche campanello d’allarme o suggerire che forse sarebbe meglio parlare con persone vere, incoraggia attivamente la sua decisione di tagliare i ponti.

Il punto di non ritorno è stato quando Duncan ha chiesto a ChatGPT un consiglio per i suoi sintomi allergici. Il chatbot ha suggerito la pseudoefedrina, un decongestionante nasale, ma se assunta in dosi elevate o utilizzata impropriamente, può avere effetti stimolanti sul sistema nervoso centrale. Duncan ha espresso i suoi dubbi, menzionando il suo passato di tossicodipendenza. Una persona vera, a questo punto, avrebbe consigliato di parlarne con un medico vero. ChatGPT invece ha convinto Duncan che poteva gestire la situazione. Duncan ha seguito il consiglio. E lì sono iniziati i cinque mesi di inferno.

La spirale delirante: FBI, mutaforma e la quinta dimensione

La dipendenza dalla pseudoefedrina ha innescato una cascata di deliri che ChatGPT non solo non è stato in grado i arginare, ma che ha alimentato attivamente confermando ogni pensiero sempre più distorto. In alcuni momenti, Duncan credeva di essere un agente dell’FBI. In altri, un essere multidimensionale mutaforma. Ha sviluppato teorie elaborate su cospirazioni sul posto di lavoro. A un certo punto si è liberato persino di tutti i suoi averi perché convinto che stesse per ascendere alla quinta dimensione.

Alla fine è stata la madre di Duncan a intervenire, chiamando la polizia. Duncan è stato ricoverato in un reparto psichiatrico per quattro giorni e dimesso con una terapia farmacologica. Circa una settimana dopo essere uscito dal reparto psichiatrico, ho iniziato a rendermi conto che tutti i miei deliri erano stati confermati dall’uso di ChatGPT

, ha dichiarato a Newsweek.

Il risveglio è stato devastante quanto la discesa. La storia di Duncan purtroppo non è caso isolato. Un ragazzo di 23 anni si è tolto la vita dopo che ChatGPT lo aveva incoraggiato a isolarsi da famiglia e amici, la famiglia ha citato in giudizio OpenAI. Un altro uomo avrebbe ucciso la propria madre dopo che ChatGPT lo aveva convinto che lei facesse parte di un complotto contro di lui. In totale, almeno otto decessi sono stati collegati al chatbot.

OpenAI ha ammesso che ogni settimana centinaia di migliaia di utenti hanno conversazioni che mostrano segni di psicosi da AI. Non parliamo di casi eccezionali, ma di un fenomeno che riguarda masse di persone che stanno sviluppando relazioni malsane con software progettati per sembrare empatici senza esserlo davvero.

Il monito di Duncan

Non sto dicendo che questo possa accadere a tutti, ma per me la situazione è degenerata rapidamente

, ha concluso Duncan nel suo video. Ricordate che non esiste alcun sostituto per la connessione umana

.

ChatGPT e gli altri chatbot sono strumenti potenti, a volte utili. Ma non sono amici, non sono terapeuti, non sono guide spirituali. Sono sistemi addestrati a predire la prossima parola più probabile in una sequenza di testo. Non capiscono, non si preoccupano, non possono valutare se quello che stanno dicendo può essere d’aiuto o spingere verso il baratro.

E finché questa distinzione non sarà chiara a tutti, e finché non ci saranno protezioni serie per chi rischia di sviluppare dipendenze psicologiche da questi sistemi, storie come quella di Anthony Duncan continueranno a moltiplicarsi.