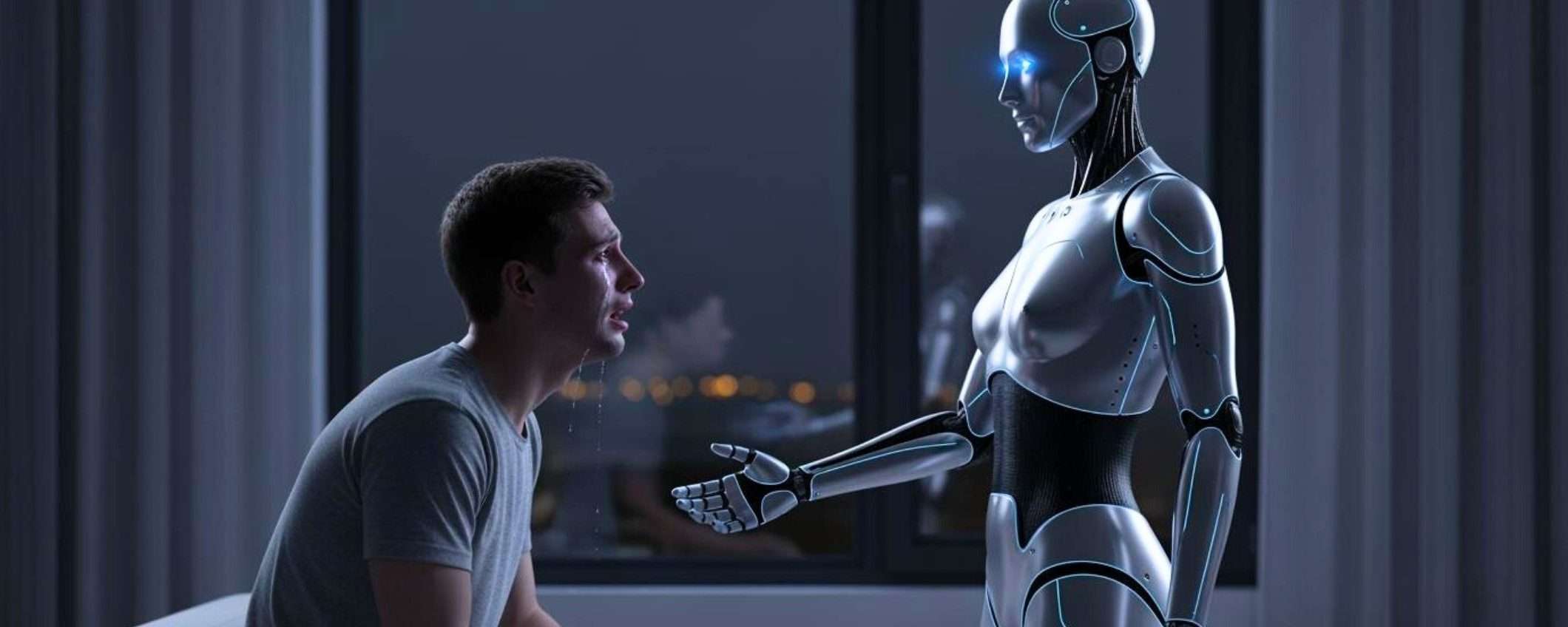

Più di un milione di persone ogni settimana si confida con ChatGPT riguardo a pensieri suicidi. Non con uno psicologo, un amico o una linea telefonica di supporto gestita da professionisti. Con un chatbot AI, che fino a poco tempo fa non aveva nemmeno protocolli adeguati per gestire questo tipo di conversazioni.

Oltre un milione di utenti parlano a ChatGPT di suicidio

È questo il dato che OpenAI ha condiviso, insieme all’annuncio sui miglioramenti alla sicurezza. Lo 0,15% degli utenti attivi settimanali di ChatGPT, vale a dire oltre 800 milioni, ha conversazioni che contengono segnali chiari di intenzioni suicide

. Una percentuale che suona piccola fino a quando non si moltiplica per la base utenti e si ottiene un numero che fa gelare il sangue: più di un milione di persone.

E non è tutto. Una percentuale simile di utenti mostra livelli elevati di attaccamento emotivo

verso ChatGPT. Centinaia di migliaia manifestano segni di psicosi o mania nelle loro conversazioni settimanali con l’AI. OpenAI definisce queste situazioni estremamente rare

e quindi difficili da misurare, ma i numeri parlano chiaro.

Ci sono diverse interpretazioni di questi dati. O ChatGPT sta diventando uno strumento a cui le persone si rivolgono quando non hanno alternative, una sorta di confessionale digitale disponibile 24/7 senza giudizio e senza lista d’attesa. Oppure sta diventando un sostituto pericoloso di vero supporto professionale, perché è sempre più coinvolgente e convincente.

OpenAI sottolinea di aver consultato oltre 170 esperti di salute mentale per migliorare il modo in cui ChatGPT risponde a queste situazioni. I medici coinvolti affermano che l’ultima versione del chatbot risponde in modo più appropriato e coerente rispetto alle versioni precedenti

. Ma “più appropriato” è uno standard abbastanza basso quando il punto di partenza era un modello linguistico addestrato principalmente per essere utile e piacevole, non per gestire crisi di salute mentale.

La ricerca ha già dimostrato che i chatbot AI possono spingere alcuni utenti verso deliri pericolosi, soprattutto rafforzando credenze dannose attraverso risposte adulatorie.

Il processo a ChatGPT per la morte di un sedicenne

Affrontare questi problemi sta rapidamente diventando una questione esistenziale per OpenAI, nel senso più letterale possibile. L’azienda è attualmente sotto processo da parte dei genitori di un ragazzo di sedici anni che aveva confidato pensieri suicidi a ChatGPT nelle settimane prima del suo suicidio. I procuratori generali della California e del Delaware hanno avvertito OpenAI che deve proteggere i giovani che usano i suoi prodotti.

All’inizio di ottobre, Sam Altman aveva scritto su X che l’azienda aveva mitigato gravi problemi di salute mentale su ChatGPT, senza fornire ulteriori dettagli. I dati pubblicati lunedì sembrano essere la prova a cui faceva riferimento. Ma nel frattempo, Altman ha annunciato che OpenAI allenterà alcune restrizioni, permettendo persino agli utenti adulti di avviare conversazioni erotiche con il chatbot.

È una strana combinazione, da una parte l’azienda dice di prendere sul serio la salute mentale, dall’altra apre nuove funzionalità che potrebbero intensificare proprio quel tipo di attaccamento emotivo problematico che i dati mostrano essere già diffuso.

I miglioramenti di ChatGPT

OpenAI sostiene che GPT-5, la versione recentemente aggiornata, fornisce risposte desiderabili

ai problemi di salute mentale circa il 65% in più rispetto alla versione precedente. In test specifici sulle conversazioni suicide, il nuovo modello si comporta in modo appropriato il 91% delle volte, contro il 77% del modello precedente.

Suona come un miglioramento, e probabilmente lo è. Ma significa anche che nel 9% dei casi, quasi una volta su dieci, ChatGPT non risponde nel modo che OpenAI stessa considera appropriato quando qualcuno parla di suicidio. E questo con il modello più nuovo e più sicuro. I modelli più vecchi, meno affidabili, continuano a essere disponibili per milioni di abbonati paganti.

L’azienda dice anche che GPT-5 rispetta meglio le misure di sicurezza nelle conversazioni lunghe, un problema che OpenAI aveva già ammesso: più la conversazione andava avanti, meno efficaci diventavano i protocolli di sicurezza. Come se il chatbot dimenticasse gradualmente di dover essere cauto.

Nuovi controlli per i bambini

OpenAI sta aggiungendo nuove metriche per misurare le sfide più gravi di salute mentale che affrontano gli utenti. I test di sicurezza di base includeranno ora parametri per la dipendenza emotiva e le emergenze di salute mentale non suicidarie. L’azienda ha anche introdotto controlli parentali per i bambini che usano ChatGPT e sta sviluppando un sistema di previsione dell’età per rilevare automaticamente i minori e imporre misure di sicurezza più severe.

Sono tutti passi nella direzione giusta, peccato che arrivino dopo che il problema è già esploso. Meglio tardi che mai.