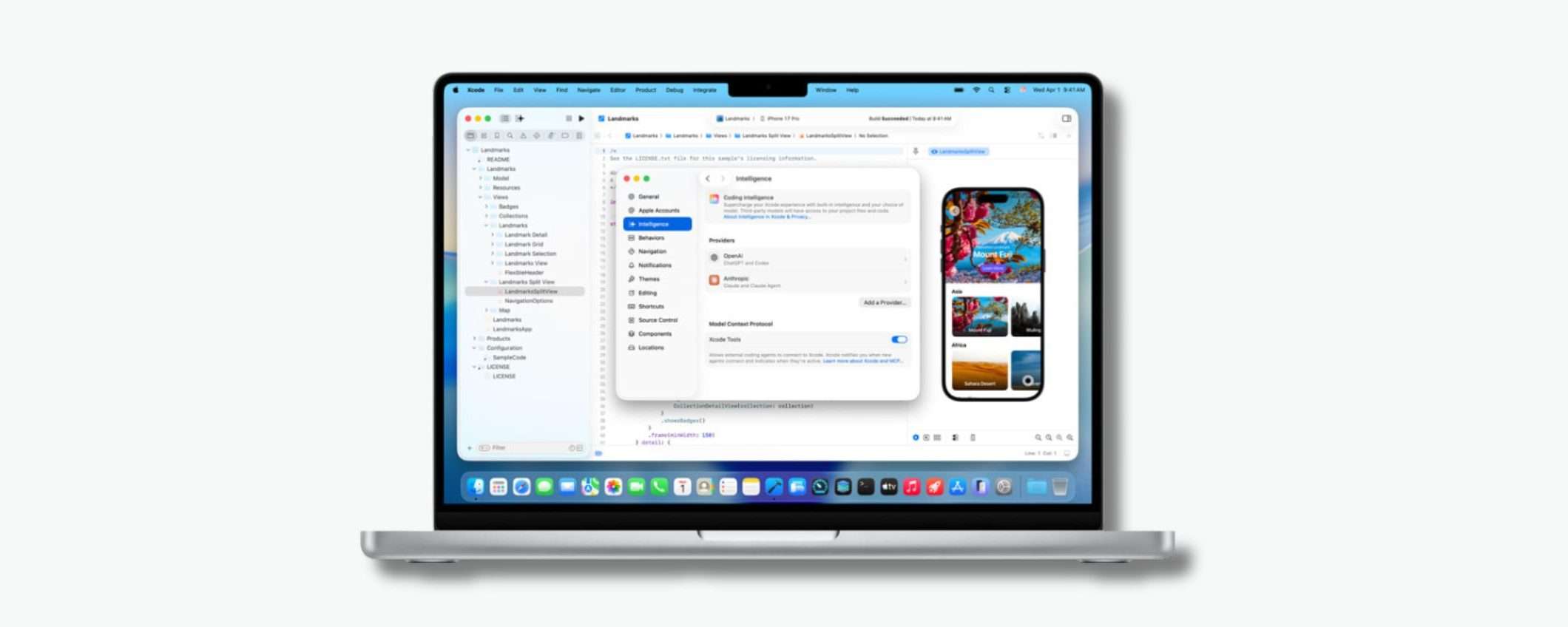

Apple ha annunciato Xcode 26.3, un aggiornamento che porta la programmazione agentica direttamente nell’IDE ufficiale per lo sviluppo di app Apple. In pratica, ora si può far lavorare Claude Agent di Anthropic e Codex di OpenAI fianco a fianco, mentre si sviluppano app per iPhone, iPad, Mac e tutto l’ecosistema Apple.

Apple integra Claude Agent e Codex in Xcode

L’AI diventa ufficialmente un membro del team di sviluppo, con tanto di accesso agli strumenti, alla documentazione e alla capacità di capire cosa diavolo si sta facendo. La Release Candidate è disponibile da oggi sul sito Apple Developer, e arriverà presto sull’App Store per tutti.

È l’evoluzione naturale di Xcode 26, rilasciato lo scorso anno, che aveva già integrato ChatGPT e Claude nell’ambiente di sviluppo. Ma quella era roba da principianti rispetto a questo. Perché ora non si parla più di assistenza passiva, ma di agenti autonomi che possono prendere decisioni, eseguire compiti complessi e gestire automazioni che prima richiedevano ore di lavoro manuale.

L’integrazione del coding agentico non è un semplice chatbot messo lì nella sidebar dell’IDE. È un accesso profondo alle funzioni di Xcode che permette agli agenti AI di fare cose concrete: esplorare i progetti, comprenderne la struttura e i metadati, compilare il codice, eseguire test per individuare bug, e persino correggere gli errori trovati.

Gli agenti hanno inoltre accesso alla documentazione ufficiale aggiornata di Apple. Perciò, quando scrivono codice, usano le API più recenti e rispettano le best practice. Apple ha dichiarato di aver lavorato a stretto contatto con Anthropic e OpenAI per ottimizzare l’uso dei token e le chiamate agli strumenti (tool calling), assicurando che gli agenti operino in modo efficiente senza sprecare risorse. Xcode, infatti, sfrutta il protocollo MCP (Model Context Protocol) per esporre le proprie capacità agli agenti.

Cosa significa in pratica? Che l’IDE può interfacciarsi con qualsiasi agente esterno compatibile con MCP, non solo quelli di Anthropic e OpenAI. È un’architettura aperta che lascia spazio a futuri competitor. Oggi Claude e Codex, domani chissà. Gemini Code? Un nuovo modello specializzato che ancora non esiste? La porta è aperta.

Come si usa

Gli sviluppatori scaricano gli agenti desiderati dalle impostazioni di Xcode e collegano i propri account tramite login o chiave API. Un menu a tendina permette di scegliere la versione specifica del modello. Poi c’è una finestra di prompt sul lato sinistro dello schermo dove si descrive in linguaggio naturale cosa si vuole. Non serve scrivere pseudocodice o spiegare passo-passo. Solo: Aggiungi una funzione che usi CoreML per riconoscere oggetti nelle foto, con un’interfaccia stile iOS 18 e animazioni fluide

. L’agente prende la richiesta, la scompone, e si mette al lavoro.

Mentre l’agente opera, suddivide i compiti in piccoli passaggi per rendere trasparente cosa stia facendo. Prima di scrivere anche solo una riga di codice, consulta la documentazione necessaria, proprio come farebbe uno sviluppatore coscienzioso, cosa che nella realtà succede meno di quanto dovrebbe. Le modifiche vengono evidenziate visivamente nel codice, e una cronologia sul lato dello schermo permette di monitorare ogni singola operazione.

Trasparenza per imparare, sicurezza per non impazzire

Apple insiste molto su questo aspetto della trasparenza. Non è solo una questione di fiducia verso l’AI, anche se sicuramente aiuta sapere esattamente cosa sta facendo invece di vederla sputare fuori blocchi di codice misterioso. È soprattutto pensata per i nuovi sviluppatori in fase di apprendimento.

Vedere l’agente consultare la documentazione, suddividere il problema, scrivere il codice passo dopo passo, testarlo e correggerlo diventa un tutorial interattivo. È come avere un senior developer che mostra il suo processo di lavoro in tempo reale, spiegando perché fa certe scelte.

Per questo motivo, giovedì Apple organizzerà un workshop “code-along” sul sito sviluppatori, dove gli utenti potranno imparare a usare questi strumenti in tempo reale. Sarà interessante vedere quanti sviluppatori si presenteranno e quanti invece preferiranno smanettare da soli,è sempre stata una community abbastanza indipendente.

Al termine del processo, l’agente verifica che il codice creato funzioni come previsto. Se trova bug, ripete il processo per correggerli. Apple ha anche scoperto che chiedere all’agente di “riflettere” sul piano d’azione prima di iniziare a scrivere migliora i risultati.

E se tutto va storto? Nessun problema. Xcode crea un punto di ripristino a ogni modifica effettuata dall’AI, il che significa che si può sempre tornare indietro e annullare tutto se il risultato non soddisfa. È il paracadute di sicurezza che rende l’esperimento meno rischioso, si prova a far lavorare l’agente, nel peggiore dei casi si preme undo e si torna dove si era.

La fine della programmazione manuale?

Non esageriamo. L’AI diventa un collaboratore molto più capace del passato. Gli sviluppatori continuano a decidere cosa sviluppare, come strutturarlo, quali compromessi accettare. Ma delegano all’AI il lavoro ripetitivo, la consultazione della documentazione, la scrittura del boilerplate code che tutti odiano ma che serve.

E considerando che Xcode è l’ambiente ufficiale e obbligatorio per chi vuole pubblicare app sull’App Store, questa integrazione avrà un impatto enorme sull’ecosistema. Non è un tool di nicchia che qualche smanettone userà per divertimento. È una funzionalità mainstream che milioni di sviluppatori avranno a disposizione.

Chissà come reagirà la community. Alcuni sviluppatori abbracceranno gli agenti come liberatori che finalmente li sollevano dalle parti noiose del lavoro. Altri saranno scettici, preoccupati per la qualità del codice generato o per la dipendenza crescente da strumenti esterni. E qualcuno, inevitabilmente, si lamenterà. Ma la direzione è chiara: il coding agentico non è più un esperimento. È il futuro che Apple sta costruendo.