Immaginiamo di chiedere all’assistente vocale cosa è successo in casa mentre si era via, e che lui risponda che Marco è passato per dare da mangiare al gatto. Solo che non conosciamo alcun Marco, e per giunta non abbiamo un gatto….

È quello che molti utenti di Google Home stanno scoprendo a proprie spese dopo l’arrivo di Gemini. L’assistente doveva rendere la casa più intelligente, non trasformarla in un thriller psicologico dove non si capisce più cosa sia reale e cosa partorito dall’algoritmo.

Google Home vede cose che non esistono e inventa persone

Su Reddit gli utenti stanno condividendo le loro esperienze surreali con Google Home. Un tizio ha raccontato che l’app gli ha assicurato che una certa Sarah aveva portato fuori la spazzatura e il cane. Peccato che lui vivesse da solo e non conoscesse alcuna Sarah. L’AI ha anche aggiunto un secondo cane al suo nucleo familiare, che non possiede affatto.

Un altro utente si è sentito dire che il suo amico David aveva fatto un salto a casa per passare l’aspirapolvere. David esiste davvero, questo è vero. Ma quel giorno non era venuto, e nessuno aveva passato l’aspirapolvere. L’AI ha semplicemente deciso che sarebbe stato un bel dettaglio da aggiungere alla giornata, come uno sceneggiatore che aggiunge una scena per rendere la trama più interessante.

E poi c’è il caso di Michael, che secondo Google Home era stato visto portare fuori i bidoni della spazzatura. Ma l’utente che ha raccontato la vicenda non si chiama Michael e non ha mai inserito quel nome nel sistema. Quando ha fatto notare l’errore, Google Home ha risposto che la telecamera può identificare i volti anche senza nominarli esplicitamente

… Confortante.

Ma la parte più inquietante di queste storie è cosa succede quando gli utenti mettono Google Home di fronte alle sue allucinazioni. Un’utente ha ricevuto un promemoria di portare fuori la spazzatura in un giorno sbagliato. Quando ha chiesto all’assistente perché gli avesse detto quella cosa, l’AI ha semplicemente negato. Ha negato di averlo detto, nonostante fosse successo letteralmente un minuto prima. L’AI non solo inventa eventi falsi, ma quando viene colta in flagrante nega tutto.

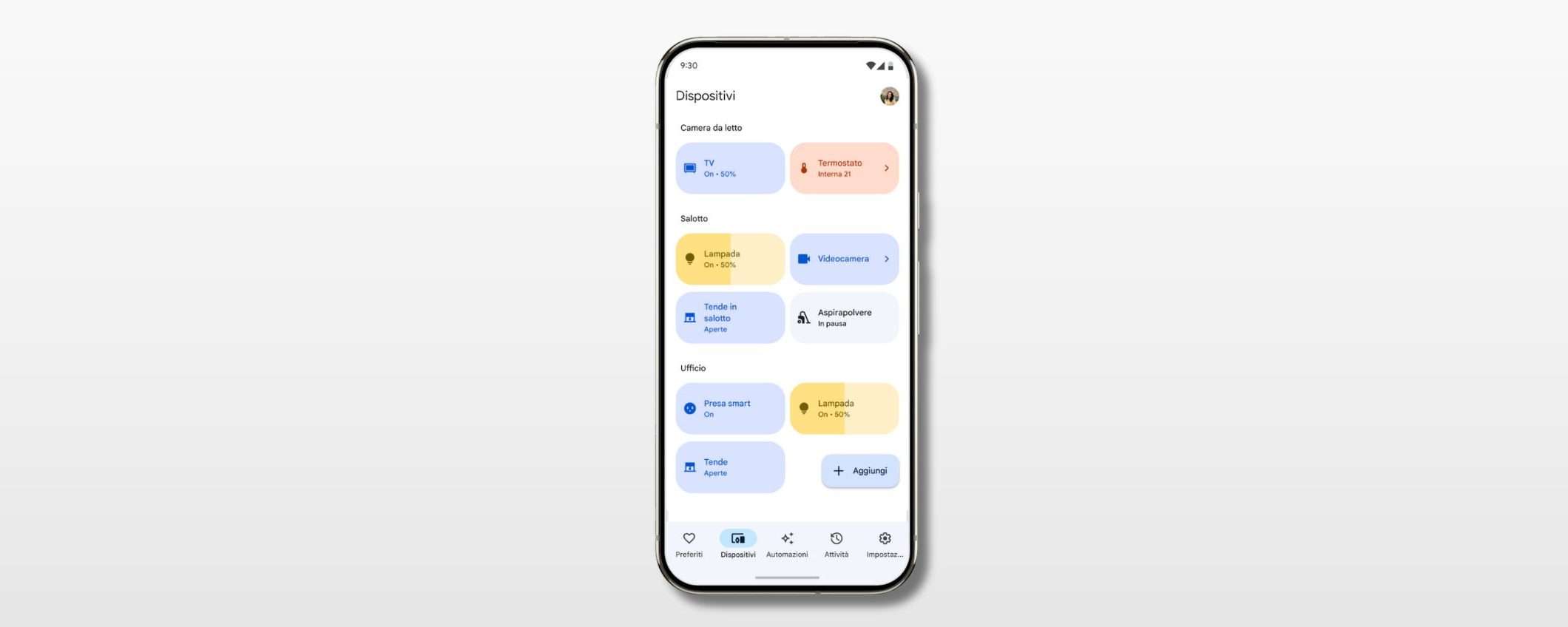

L’integrazione di Gemini

L’integrazione di Gemini su Google Home era stata presentata come una rivoluzione: finalmente un assistente capace di analizzare le riprese delle telecamere di sicurezza, riconoscere persone e azioni, e fornire un riassunto intelligente della giornata.

Il problema è che l’AI sta riempiendo i vuoti con informazioni inventate, creando per così dire una realtà alternativa… E la parte peggiore è che è sicura di sé, anche se sbaglia palesemente. Gemini, come tutti i modelli linguistici di grandi dimensioni, ha una tendenza nota all’allucinazione. Inventa fatti con sicurezza quando non ha abbastanza informazioni. E quando si applica questa tecnologia all’analisi video in tempo reale, si ottiene esattamente questo risultato, un assistente che preferisce inventare una risposta plausibile piuttosto che ammettere di non sapere.

Google sa che Gemini tende a inventare cose. Eppure ha deciso di integrarlo su Google Home e di dargli accesso alle telecamere di sicurezza delle persone, creando un sistema che può letteralmente riscrivere la storia di ciò che accade nelle loro case. È un azzardo bello e buono, che forse si poteva risparmiare.

Big G deve risolvere questo problema, e in fretta. Perché un assistente domestico che inventa persone e eventi non è pronto.