Solo pochi giorni fa un sistema di intelligenza artificiale, denominato Benjamin , ha dimostrato un certo talento nel redigere la sceneggiatura per il cortometraggio di fantascienza “Sunspring”. Sempre nel campo cinematografico, tocca ora ad un’altra AI distinguersi, questa volta assumendo il ruolo di rumorista. I ricercatori del Computer Science e Artificial Intelligence Laboratory (CSAIL) del Massachusetts Institute of Technology (MIT) hanno sviluppato un algoritmo di deep learning in grado di analizzare un video muto e ricavarne gli effetti sonori dai singoli fotogrammi. L’applicazione si è già dimostrata molto efficace, riuscendo a convincere gli spettatori che i suoni di una clip video provenissero da un ambiente reale.

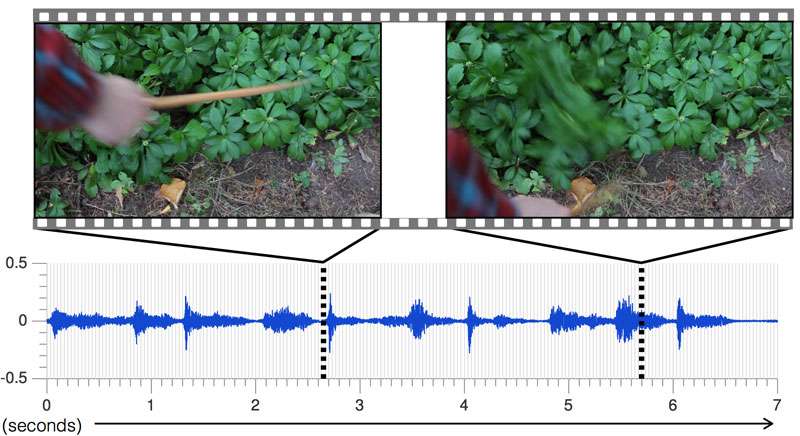

Nell’ articolo intitolato Visually Indicated Sounds , che sarà presentato nei prossimi giorni al Computer Vision and Pattern Recognition , il team del MIT spiega l’approccio seguito per lo sviluppo dell’algoritmo, addestrato nell’analisi di una mole significativa di dati. Il team di ricerca ha iniziato con la creazione di un database che raccoglie circa un migliaio di video contenenti circa 46mila suoni prodotti da numerosi oggetti percossi da una bacchetta per batteria. Per identificare un suono, l’AI deve riconoscere il tipo di materiale e la modalità di interazione con la bacchetta.

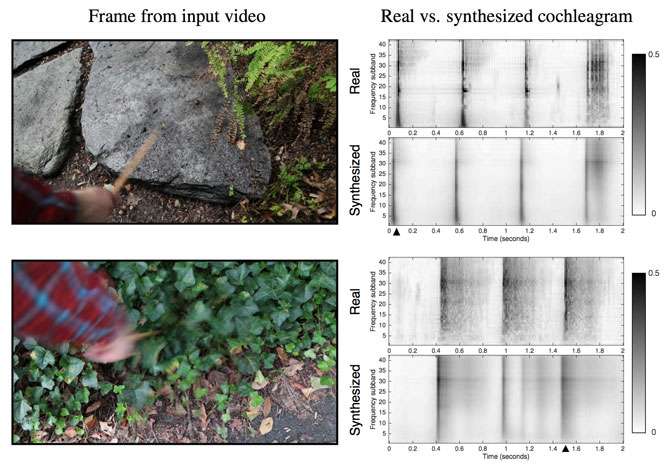

L’applicazione analizza il database per scomporre i suoni, individuandone l’altezza (frequenza), l’intensità ecc. Per scegliere l’effetto audio più adatto ad una azione, l’algoritmo studia fotogramma per fotogramma i segnali audiovisivi provenienti dai video in esame. Trasforma quindi i campioni in onde sonore per il confronto con il suono più adatto presente nel database. Per valutare l’efficacia della loro AI, gli esperti del CSAIL hanno chiesto ad un gruppo di volontari di osservare due video, uno contenente suoni reali, l’altro suoni prodotti dall’algoritmo. In due casi su tre il pubblico ha identificato il suono artificiale come reale. L’AI ha quindi gestito l’equivalente di un test di Turing per il suono, che apre prospettive promettenti per questa tecnologia.

L’algoritmo ha ancora forti limitazioni che gli impediscono di riconoscere alcuni suoni, partendo dal fatto che deve essere collegato ad un’ azione fisica visivamente identificabile . L’AI non è cioè in grado di riconoscere il suono della brezza, il cinguettio degli uccelli o il ronzio di un’auto. Almeno per ora, gli addetti alla sonorizzazione di film e serie TV possono stare tranquilli. I ricercatori assicurano però che le future versioni dell’algoritmo potrebbero essere un giorno in grado di sostituirli completamente.

La tecnologia, infine, troverebbe una potenziale applicazione nella robotica. L’analisi dei suoni del team di ricerca, infatti, potrebbe essere impiegata per determinare le proprietà fisiche dei materiali. I ricercatori hanno creato un ulteriore algoritmo in grado di distinguere i suoni prodotti su una superficie dura da quelli derivanti da una superficie morbida, con una precisione del 67 per cento. Ad esempio, incontrando un marciapiede rivestito con erba, un robot potrebbe utilizzare il riferimento sonoro delle due superfici per dedurre cosa accadrebbe se dovesse camminare o rotolare su una o sull’altra. La tecnica potrebbe aiutare i robot a prevedere le conseguenze delle proprie interazioni con il mondo esterno.

Thomas Zaffino