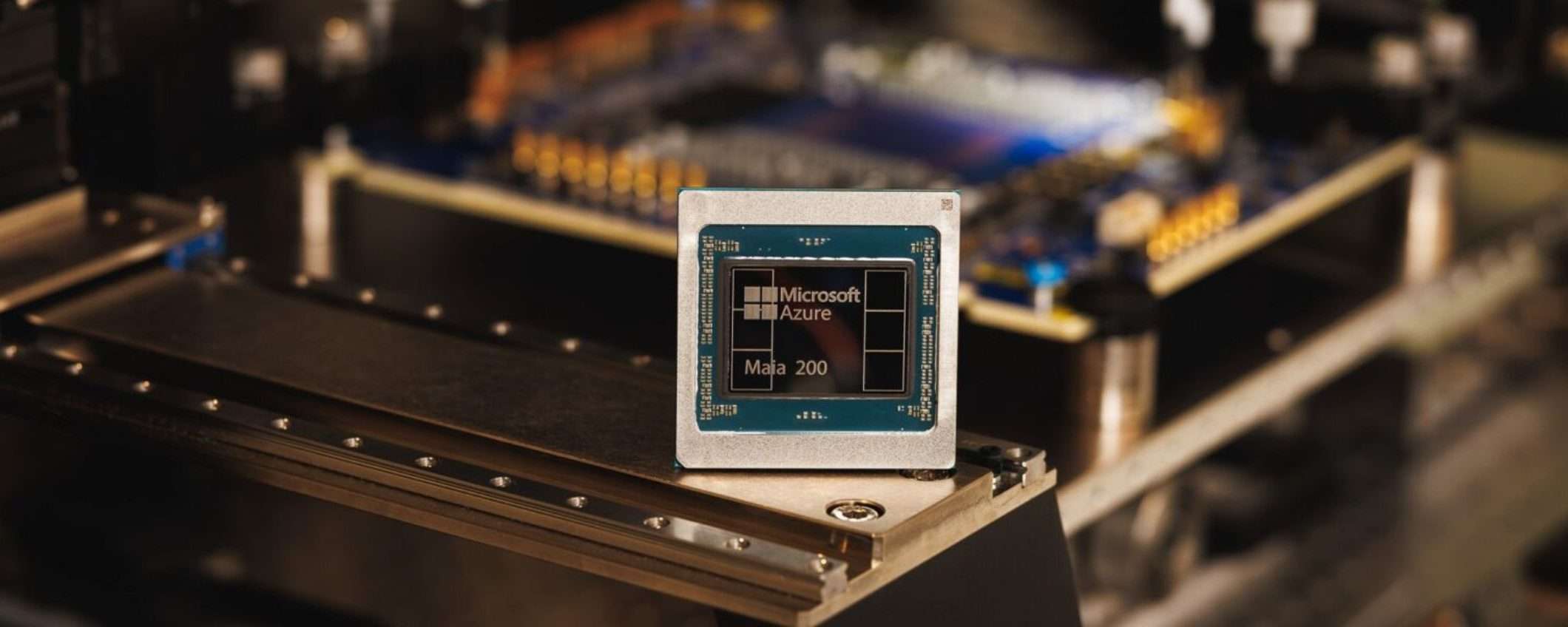

Microsoft ha fatto le scarpe ad Amazon e Google. O almeno ci sta provando. Oggi ha annunciato Maia 200, il suo secondo chip AI proprietario, costruito con processo a 3nm di TSMC e progettato per far girare i modelli AI più grandi del mondo senza sudare. Più di 100 miliardi di transistor, prestazioni FP4 tre volte superiori al Trainium di Amazon, e prestazioni FP8 che battono le TPU di Google.

Microsoft Maia 200: il chip che batte Amazon e Google

Numeri che impressionano. Ma soprattutto, un cambio di tono radicale rispetto al 2023, quando Microsoft aveva lanciato il Maia 100 senza fare confronti diretti con la concorrenza. Ora invece sbandiera i benchmark in faccia ad Amazon e Google. La posta in gioco? Il controllo dell’infrastruttura AI. Chi ha i chip migliori, ha i data center più potenti, ha i modelli più veloci, ha i clienti. E Microsoft vuole tutti e tre.

Maia 200 non è un chip qualunque. È costruito con processo a 3nm, la tecnologia di fabbricazione più avanzata disponibile oggi, quella che Apple usa per i suoi chip M4. Più di 100 miliardi di transistor impacchettati in un singolo chip, progettati specificamente per carichi di lavoro AI su larga scala.

Maia 200 può far girare senza sforzo i modelli più grandi di oggi, con ampi margini di crescita per modelli ancora più imponenti in futuro

, ha dichiarato Scott Guthrie, vicepresidente esecutivo della divisione Cloud e AI di Microsoft.

In soldoni, può ospitare GPT-5.2 di OpenAI, il modello che ancora non è stato annunciato ufficialmente ma che tutti sanno che sta per arrivare. E può scalare per modelli ancora più grandi, quando GPT-6 o GPT-7 diventeranno troppo enormi per girare su hardware normale.

Microsoft userà Maia 200 per Foundry e Copilot, i suoi servizi AI di punta. E il team Superintelligence di Microsoft, il gruppo che lavora su AGI e oltre, sarà il primo a metterci le mani sopra.

Amazon e Google non stanno a guardare

Certo, Amazon e Google non staranno fermi. Amazon sta lavorando su Trainium 4, il suo chip AI di prossima generazione, e sta collaborando con Nvidia per integrarlo con NVLink 6 e l’architettura rack MGX. Google continua a sviluppare le sue TPU, che sono già alla settima generazione e che alimentano tutti i servizi AI di Google, da Gemini a YouTube.

La corsa ai chip AI proprietari è diventata strategica. Per anni, tutti dipendevano da Nvidia. Le sue GPU A100 e H100 dominavano il mercato. Ma Nvidia ha un problema, non riesce a produrre abbastanza chip per soddisfare la domanda. E i prezzi sono esorbitanti. Quindi i giganti tech hanno deciso di fare i chip da soli. Amazon con Trainium, Google con TPU, Microsoft con Maia. Tutti vogliono l’indipendenza da Nvidia.

Distribuzione immediata nei data center Azure

Maia 200 è già operativo nei data center Azure. Le aziende che usano il cloud Microsoft possono iniziare subito a utilizzarlo pagando per l’uso, come avviene per GPU e altre risorse di calcolo. E Microsoft sta aprendo le porte a sviluppatori, accademici, laboratori di AI e progetti open-source con un’anteprima del kit di sviluppo software (SDK). Vuole creare un ecosistema attorno a Maia, non solo venderlo come commodity.