Meta AI ha recentemente rilasciato OpenEQA, un innovativo set di dati di riferimento open-source progettato per valutare la capacità di un sistema di intelligenza artificiale di rispondere a prompt utilizzando informazioni visive. Questo benchmark mira a misurare la comprensione del mondo reale da parte di un’AI, consentendole di rispondere a domande in linguaggio naturale su un ambiente specifico.

Un dataset completo e diversificato

OpenEQA comprende oltre 1.600 domande su più di 180 ambienti del mondo reale, come case e uffici. Le domande sono suddivise in sette categorie, che mettono alla prova le capacità di un’IA in abilità come il riconoscimento di oggetti, il ragionamento spaziale e la conoscenza del senso comune. Questo benchmark mira a far progredire l’intelligenza incarnata, consentendo agli agenti AI di percepire e interagire con il mondo come gli esseri umani.

Il progetto OpenEQA si colloca all’incrocio tra alcune delle aree più calde dell’intelligenza artificiale, tra cui computer vision, elaborazione del linguaggio naturale, robotica e rappresentazione della conoscenza (una branca dell’AI che studia il modo in cui avviene il ragionamento umano). L’obiettivo finale è sviluppare agenti artificiali in grado di percepire e interagire con il mondo, comunicare in modo naturale con gli esseri umani e attingere alla conoscenza per assisterci nella vita quotidiana.

Potenziali applicazioni future

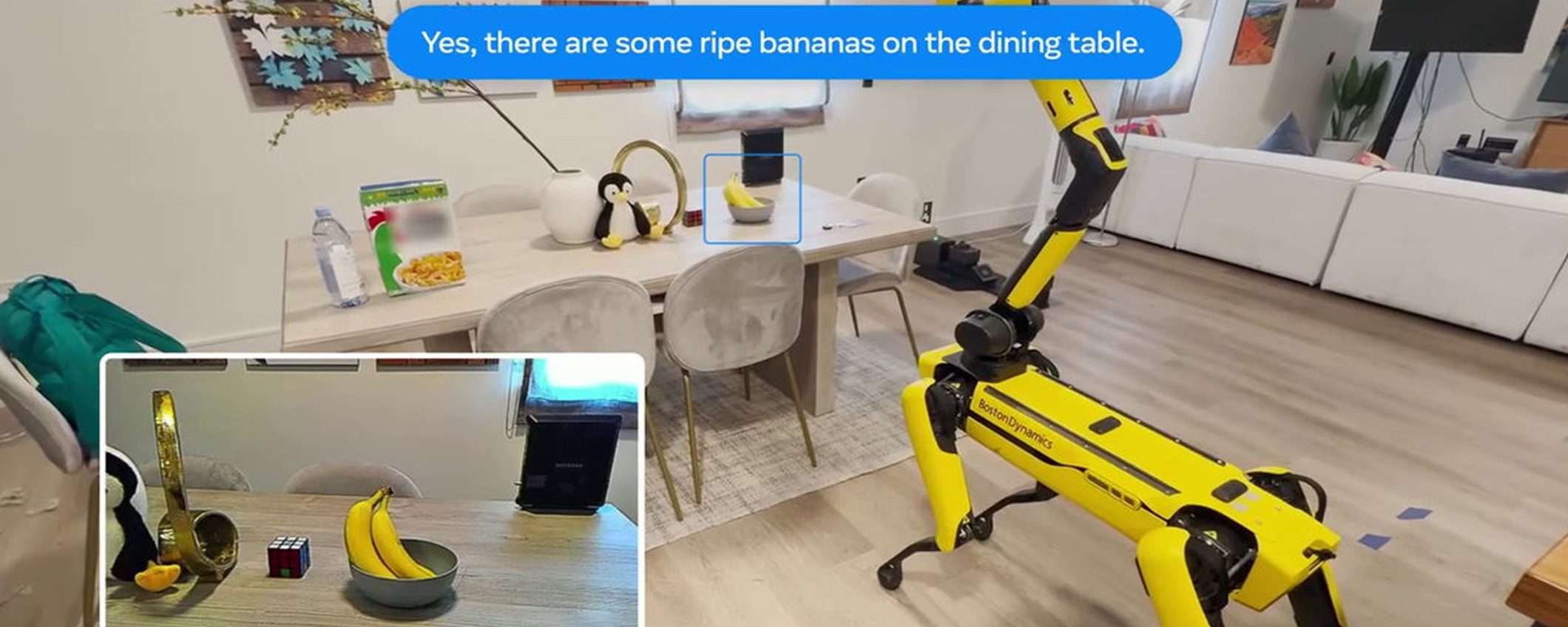

I ricercatori intravedono due principali applicazioni per questa “intelligenza incarnata” nel prossimo futuro. La prima riguarda assistenti AI integrati in dispositivi di realtà aumentata, come occhiali o visori, che potrebbero sfruttare dati video e di altri sensori per fornire all’utente una memoria fotografica, rispondendo a domande come “Dove ho lasciato le chiavi?“. La seconda applicazione coinvolge robot mobili in grado di esplorare autonomamente un ambiente per trovare informazioni, ad esempio perlustrando una casa per rispondere alla domanda “Mi è rimasto del caffè?“.

Come è stato creato il benchmark

Per creare il set di dati OpenEQA, i ricercatori di Meta hanno raccolto dati video e scansioni 3D di ambienti reali, per poi mostrare i video a partecipanti umani, chiedendo loro di generare domande che avrebbero potuto porre a un assistente AI con accesso a quei dati visivi. Le 1.636 domande risultanti mettono alla prova un’ampia gamma di capacità di percezione e ragionamento, richiedendo all’IA di riconoscere oggetti, comprendere concetti spaziali e contare elementi pertinenti.

Ogni domanda include anche risposte generate da più esseri umani, per tenere conto della varietà di modi in cui si può rispondere. Per valutare le prestazioni degli agenti IA, i ricercatori hanno utilizzato modelli linguistici di grandi dimensioni per misurare automaticamente la somiglianza tra le risposte generate dall’IA e quelle umane.