Mentre gli utenti rimasti fedeli a Thunderbird aspettano con tanta, tanta pazienza l’arrivo di Thunderbird 3 – che per altro non sembra promettere nulla di rivoluzionario – un gruppo di ex sviluppatori di Mozilla ha deciso di dare un seguito non ufficiale a Thunderbird 2. Il risultato è Postbox , un client di posta elettronica basato sullo stesso framework di Thunderbird ma dotato di un’interfaccia più accattivante e di alcune funzionalità inedite.

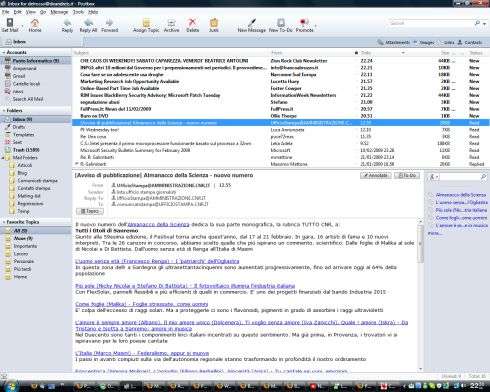

La prima beta pubblica del programma, disponibile qui per Windows e Mac OS X, migliora Thunderbird sostanzialmente in quattro aree: la ricerca di messaggi e parole chiave , che può essere effettuata con un maggior numero di criteri e utilizzando il linguaggio naturale (ad esempio, “before june 2008”); la gestione dei contenuti delle email , come allegati, link, immagini e contatti, che vengono elencati ordinatamente in un pannello a lato del messaggio e che possono essere facilmente inclusi in altre email; la gestione e l’organizzazione dei messaggi , che utilizza una visuale a thread (ogni conversazione viene racchiusa in un singolo thread) e permette di assegnare a ciascun messaggio un argomento (topic), concetto che estende quello alla base delle etichette (label) di Thunderbird 2; l’integrazione con i servizi Web 2.0 , quali i social network e i motori di ricerca.

La prima beta pubblica del programma, disponibile qui per Windows e Mac OS X, migliora Thunderbird sostanzialmente in quattro aree: la ricerca di messaggi e parole chiave , che può essere effettuata con un maggior numero di criteri e utilizzando il linguaggio naturale (ad esempio, “before june 2008”); la gestione dei contenuti delle email , come allegati, link, immagini e contatti, che vengono elencati ordinatamente in un pannello a lato del messaggio e che possono essere facilmente inclusi in altre email; la gestione e l’organizzazione dei messaggi , che utilizza una visuale a thread (ogni conversazione viene racchiusa in un singolo thread) e permette di assegnare a ciascun messaggio un argomento (topic), concetto che estende quello alla base delle etichette (label) di Thunderbird 2; l’integrazione con i servizi Web 2.0 , quali i social network e i motori di ricerca.

Al pari di Thuderbird 3, anch’esso ancora allo stadio di beta, Postbox implementa i tab , rendendo così possibile aprire in una nuova scheda messaggi, lista dei contatti, cartelle, ricerche, allegati ecc.

A differenza di Thunderbird, Postbox mostra solo le cartelle relative all’account di posta selezionato: chi ha un elevato numero di cartelle può trovare questa funzione utile, perché riduce gli elementi visualizzati nella barra laterale; in caso contrario, questa scelta può risultare scomoda, perché costringe l’utente ad un click in più (selezione dell’account più selezione della cartella).

In Postbox i topic hanno un ruolo centrale nell’organizzazione dei messaggi, e lo dimostra il fatto che questi sono visualizzati proprio sotto gli account e le cartelle, nella barra laterale: con un solo click l’utente può così scegliere, in qualsiasi momento, di visualizzare solo le mail relative al lavoro, quelle personali o, ancora, quelle ad alta priorità.

Il neonato client di posta elettronica offre poi all’utente la Composite Sidebar , che semplifica l’inserimento, all’interno di un nuovo messaggio, di contenuti presenti sul disco del PC, all’interno di altre email (immagini, link o contatti) o persino sul web, come mappe e dizionari. L’integrazione con il web si concretizza anche nella possibilità di uploadare contatti su Facebook o foto su Picasa.

Tra le altre funzionalità degne di nota c’è la possibilità di utilizzare le email per annotare cose da fare e appuntamenti . Sul fronte della sicurezza è invece presente un filtro antiphishing e antimalware che controlla tutti gli URL che vengono aperti all’interno del client. Contribuisce a rafforzare la sicurezza del programma anche la funzione di aggiornamento automatico , ormai praticamente d’obbligo in questo genere di applicazioni.

Attualmente Postbox manca di un sistema per i plug-in come quello di Thunderbird, limitandone pesantemente l’espandibilità: non è ad esempio possibile abbinare a questo programma un tool per il PIM come Lightning.

Agli utenti di Thunderbird farà enorme piacere apprendere che Postbox è in grado di importare tutti i loro messaggi , cartelle, impostazioni, password e regole antispam: una funzione che in redazione siamo riusciti a utilizzare con successo persino con la beta di Thunderbird 3. Gli altri client supportati sono SeaMonkey/Netscape e Outlook Express.

Con il rilascio della prima beta pubblica di Postbox, con numero di versione 1.0b7 (2009020812), il team di sviluppo ha inaugurato anche il sito web e il blog ufficiale. Qui si apprende che alla fase privata di beta testing hanno partecipato oltre 10mila persone.

“Il nostro obiettivo è semplice: aiutarti ad essere più produttivo ed efficiente offrendoti la miglior esperienza di messaggistica possibile”, ha dichiarato Sherman Dickman, ex dirigente di Mozilla. Tra gli altri ideatori di Postbox c’è Scott MacGregor, uscito dal team di sviluppo di Thunderbird nel 2007 dopo la costituzione di Mozilla Messaging , società controllata da Mozilla Foundation con lo scopo di separare le attività di sviluppo e marketing di Firefox da quelle inerenti a Thunderbird ed eventuali futuri prodotti per la messaggistica e la comunicazione.

La prima versione stabile di Postbox dovrebbe vedere la luce entro la fine della primavera, e in tale occasione gli sviluppatori contano di rilasciare anche una versione per Linux . Per il momento nulla è stato detto circa la licenza sotto la quale sarà distribuito il software, ma è assai probabile che questa sarà la stessa di Thunderbird e Firefox.

I creatori di Postbox non hanno fatto alcun cenno a collaborazioni con Mozilla Messaging : per il momento il progetto appare un’iniziativa del tutto slegata a quella di Mozilla, seppure basata sulle stesse tecnologie. Di certo una fusione dei due progetti sarebbe auspicabile, ed eviterebbe un inutile dispendio di risorse ed energie.