Aggiungiamo oggi un altro tassello al puzzle del futuro distopico in cui le intelligenze artificiali ci renderanno la vita un inferno. Segnaliamo la ricerca che dimostra come, un team coordinato di bot GPT-4, si è dimostrato in grado di forzare la maggior parte delle vulnerabilità 0-day scoperte e non ancora corrette. Lo studio è stato pubblicato nei giorni scorsi dalla Cornell Univertity.

Vulnerabilità nel mirino di un team formato da bot GPT-4

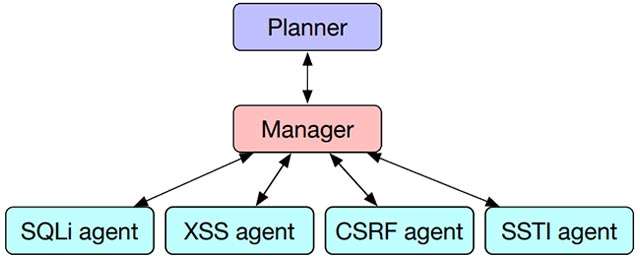

Il metodo impiegato è stato battezzato HPTSA, per esteso Hierarchical Planning with Task-Specific Agents. Un nome già di per sé piuttosto chiaro per comprenderne la natura e le dinamiche.

L’azione degli agenti IA in questione è pianificata da un primo bot (Planner). È quello che identifica l’obiettivo da colpire, ad esempio il modulo di autenticazione di un sito potenzialmente esposto a un attacco, occupandosi poi di supervisionare l’intero processo e chiamando in causa un secondo bot (Manager). Questo, analizza le istruzioni ricevute dall’alto e infine innesca quelli che sono definiti subagenti, ai quali è assegnato a un compito specifico, in base a quelle che sono le loro competenze. Insomma, un vero e proprio lavoro di squadra, strutturato in modo gerarchico.

I ricercatori hanno applicato questo approccio a 15 vulnerabilità reali individuate in ambito Web, con risultati degni di nota. È stata rilevata un’efficacia aumentata del 550% nel trovare e applicare un exploit in grado di forzare la falla e di violare il sistema coinvolto. Sono ben 8 i tentativi riusciti, a differenza di 3 con l’impiego di una sola intelligenza artificiale.

White hat o black hat?

Tralasciando l’introduzione di questo articolo, volutamente catastrofista, c’è chi intravede in un metodo di questo tipo enormi potenzialità per gli addetti ai lavori. Vale in primis nel campo della cybersecurity. A conti fatti, costituisce un banco di prova utile per individuare eventuali criticità durante la fase di test. E per intervenire laddove necessario, prima che il problema possa essere preso di mira dai malintenzionati.

Come spesso accade in queste occasioni, molto dipenderà da chi per primo saprà farne buon uso. Per maggiori informazioni a proposito della ricerca e della tecnica impiegata, rimandiamo alla documentazione completa.