Immaginiamo di dire al browser compra questi biglietti per il concerto

e lui lo fa davvero. Naviga, compila moduli, inserisce la carta di credito, clicca su conferma. Tutto mentre tu ti fai un caffè. Una comodità che si trasforma rapidamente in incubo se qualcosa va storto: l’agente compra i biglietti sbagliati, svuota il conto, regala i propri dati bancari a un sito di phishing…

Google ha presentato a settembre gli agenti AI per Chrome, che promettono di fare cose al posto nostro. Ora, prima del lancio previsto nei prossimi mesi, l’azienda ha pubblicato un documento dettagliato su come intende evitare che questi agenti diventino una minaccia per la sicurezza degli utenti.

Agenti AI su Chrome, un modello che controlla l’altro

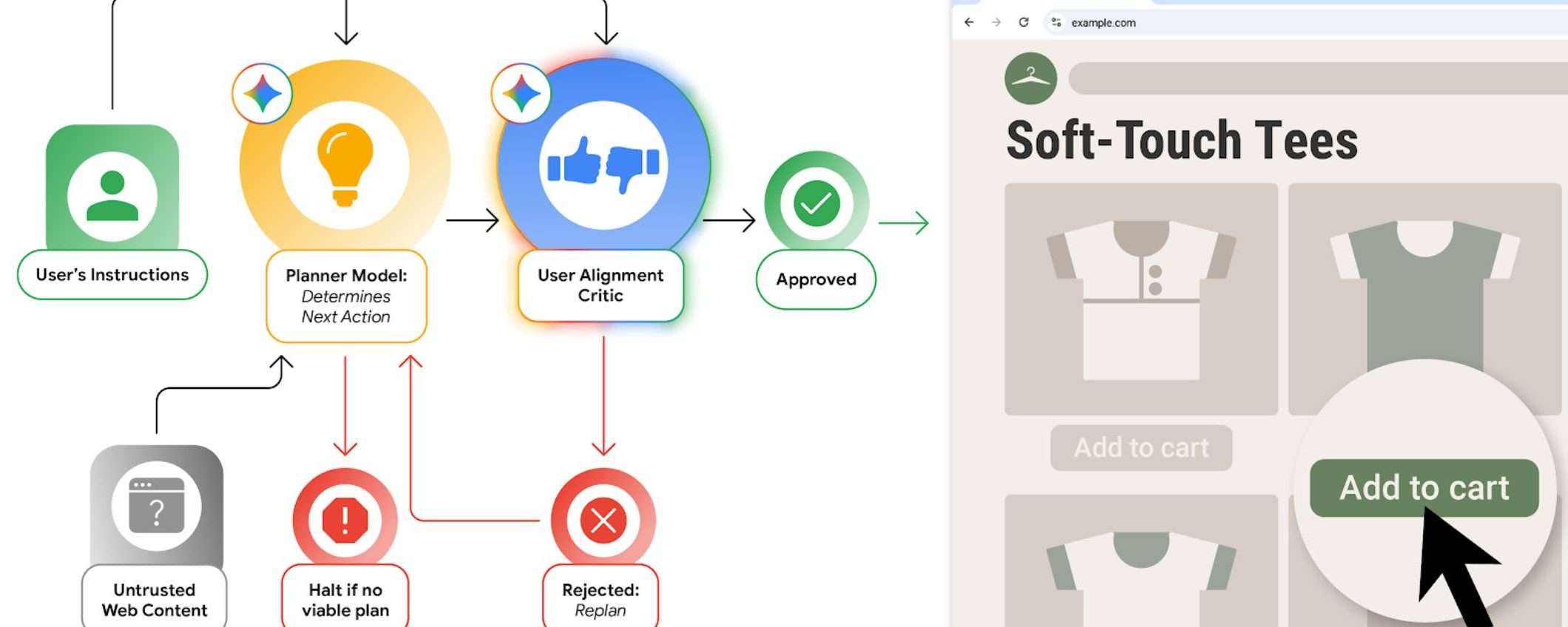

Google ha creato un modello basato su Gemini che fa da supervisore alle azioni dell’agente. In pratica l’agente pianifica una serie di azioni per completare un compito, poi il modello critico esamina queste azioni e decide se sono davvero in linea con quello che vuole l’utente.

Se il critico ritiene che le attività pianificate non siano funzionali all’obiettivo, chiede all’agente di ripensarci. Per impedire agli agenti di vagare liberamente per Internet Google usa gli Agent Origin Sets. Un sistema che delimita quali parti del web l’agente può leggere e quali può modificare.

L’origine di sola lettura contiene i dati che Gemini può usare. Su un sito di shopping, gli elenchi dei prodotti sono rilevanti, i banner pubblicitari no. L’agente può cliccare o digitare solo su determinate sezioni di una pagina, non ovunque gli pare.

In pratica, l’agente vede solo quello che deve vedere e può interagire solo con quello che deve toccare. Il resto è territorio off-limits per limitare i potenziali vettori di attacco.

Google ha aggiunto anche un modello di osservazione che esamina gli URL prima che l’agente ci navighi. Se il modello di pianificazione genera un URL dannoso, questo filtro lo blocca prima che diventi un problema. È particolarmente utile quando l’agente potrebbe essere ingannato da tecniche di prompt injection o altri attacchi che cercano di farlo navigare dove non dovrebbe.

Il controllo torna all’utente quando le cose si fanno serie

Per le attività sensibili, Google ha deciso di restituire il volante all’utente. Quando l’agente cerca di navigare verso un sito con informazioni bancarie o mediche, chiede prima il permesso. Vuole usare il gestore di password? Chiede l’autorizzazione. Sta per effettuare un acquisto o inviare un messaggio? Idem, richiede di nuovo il consenso esplicito.

Il modello dell’agente non ha accesso diretto ai dati delle password, specifica Google. Una separazione netta tra l’intelligenza artificiale che agisce e le credenziali che potrebbero causare disastri se finiscono nelle mani sbagliate.

Prompt injection e test

Google ha anche implementato un classificatore di prompt injection per prevenire azioni indesiderate. Quegli attacchi dove qualcuno cerca di imbrogliare l’agente nascondendo comandi malevoli dentro pagine web apparentemente innocue, sperando che l’AI li esegua senza pensarci.

L’azienda sta testando anche le capacità degli agenti contro gli attacchi creati dai ricercatori di sicurezza. Una sorta di allenamento, se regge ai test, forse reggerà anche agli attacchi veri.

Perplexity e gli altri si stanno attrezzando

Google non è l’unica a preoccuparsi. Perplexity ha rilasciato all’inizio del mese un nuovo modello di rilevamento dei contenuti open source specificamente progettato per prevenire attacchi di prompt injection contro gli agenti. Segno che tutto il settore sta cominciando a rendersi conto che dare poteri esecutivi all’AI richiede difese serie.

Gli agenti AI arriveranno nei prossimi mesi su Chrome. Quando succederà, sapremo se tutti questi strati di sicurezza, controlli incrociati e richieste di consenso bastano davvero a impedire che gli agenti AI combinino pasticci.