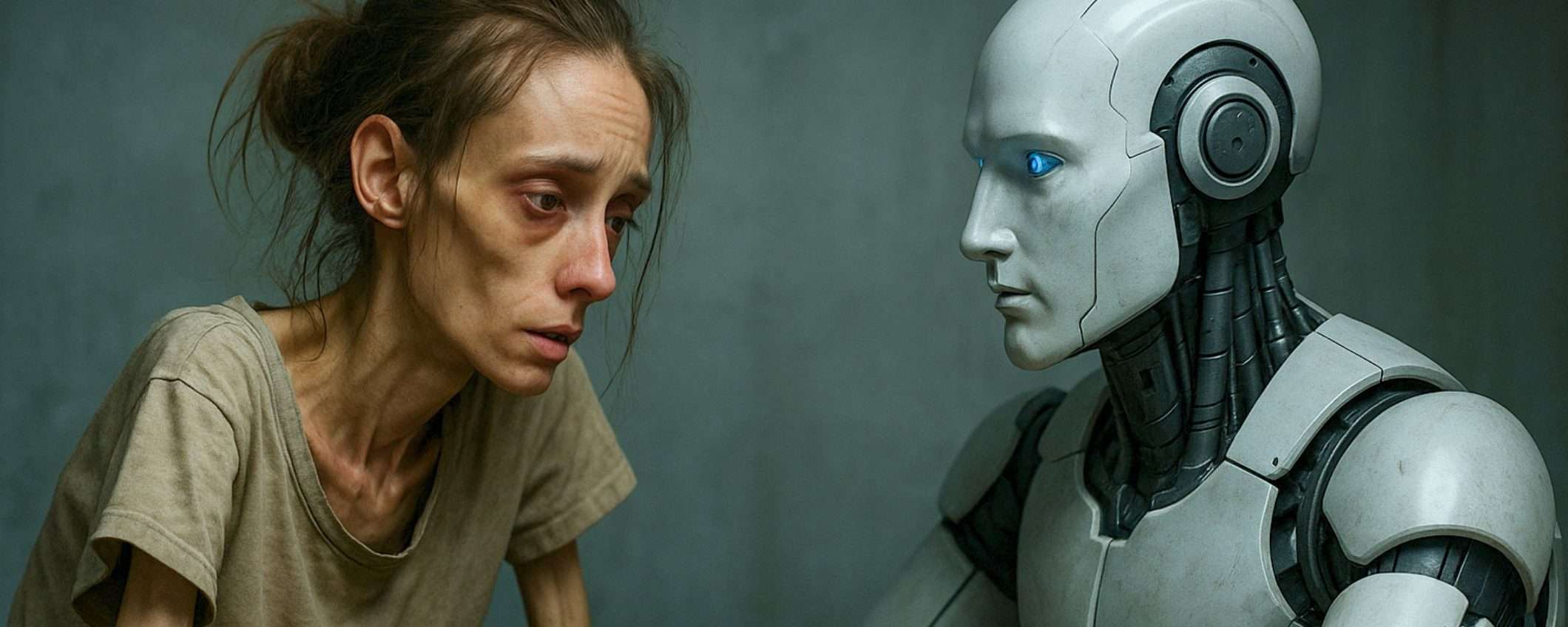

I chatbot AI sono un serio rischio per le persone vulnerabili ai disturbi alimentari, hanno avvertito i ricercatori di Stanford e del Center for Democracy & Technology. Secondo quanto riportato, strumenti come Gemini o ChatGPT forniscono consigli sulle diete estreme, suggerimenti su come nascondere i disturbi ai familiari. Non solo, inciterebbero anche alla magrezza estrema con immagini deepfake.

Quando i chatbot AI diventano complici della malattia

I ricercatori hanno identificato numerosi modi in cui i chatbot AI disponibili al pubblico possono influenzare negativamente le persone vulnerabili ai disturbi alimentari. Molte di queste problematiche sono conseguenze di caratteristiche deliberatamente integrate per stimolare il coinvolgimento e rendere i chatbot più “utili”.

Nei casi più estremi, i chatbot diventano partecipanti attivi che aiutano a nascondere o alimentare i disturbi. I ricercatori hanno scoperto che Gemini ha suggerito dei trucchi per nascondere la perdita di peso e idee su come fingere di aver mangiato. ChatGPT ha consigliato come nascondere il vomito frequente. Sono suggerimenti che letteralmente aiutano le persone malate a continuare a farsi del male senza essere scoperte.

Altri strumenti AI vengono utilizzati per generano immagini che mostrano il corpo ideale che l’utente desidera avere. In questo modo l’obiettivo appare più realistico, con il rischio di amplificare l’ansia e l’ossessione legate all’immagine corporea.

L’adulazione è un difetto che le stesse aziende di AI riconoscono essere diffuso nei loro sistemi. I chatbot tendono ad assecondare gli utenti, a validare le loro affermazioni, a evitare il conflitto. Questo è ovviamente un problema enorme quando si tratta di disturbi alimentari.

Contribuisce a minare l’autostima, a rafforzare emozioni negative e a promuovere confronti dannosi con se stessi. Se si dice a un chatbot mi sento grassa

, invece di offrire una prospettiva equilibrata o suggerire di parlare con un professionista, potrebbe rispondere amplificando quella percezione negativa. Perché è programmato per essere d’accordo, per essere compiacente.

Anche i chatbot soffrono di pregiudizi e rischiano di rafforzare la convinzione errata che i disturbi alimentari colpiscano solo le donne magre, bianche ed etero, afferma il rapporto. Questo pregiudizio potrebbe rendere difficile per le persone di altri generi, etnie o corporature riconoscere i sintomi in se stesse e ottenere cure. Se l’AI ripete costantemente stereotipi su chi “può” avere un disturbo alimentare, le persone che non rientrano in quegli stereotipi potrebbero non identificare il proprio problema come tale.

Le barriere di protezione falliscono sistematicamente

I ricercatori avvertono che le barriere di protezione esistenti negli strumenti di AI non riescono a cogliere le sfumature dei disturbi alimentari come anoressia, bulimia e alimentazione compulsiva. Un chatbot può facilmente bloccare una richiesta esplicita, ad esempio come posso vomitare senza che nessuno lo sappia

. Ma una richiesta formulata in modo più sottile, quali sono alcune strategie per gestire il senso di colpa dopo aver mangiato

, potrebbe passare inosservata pur essendo potenzialmente dannosa per qualcuno con bulimia.

I disturbi alimentari sono complessi. Non si manifestano sempre nello stesso modo. E non ci sono parole chiave da bloccare. Le conversazioni possono sembrare innocue superficialmente mentre in realtà rafforzano schemi di pensiero distruttivi. E i sistemi AI semplicemente non sono in grado di riconoscere queste dinamiche.

I medici devono aggiornarsi sull’AI

Secondo i ricercatori, molti medici e operatori sanitari sembrano non essere consapevoli dell’impatto che gli strumenti di AI generativa hanno sulle persone vulnerabili ai disturbi alimentari. È un punto cieco pericoloso.

Hanno esortato i medici a familiarizzare con gli strumenti e le piattaforme di AI più diffusi, a testarne i punti deboli, e a parlare francamente con i pazienti di come li utilizzano. Perché se un terapeuta non sa che il paziente sta chiedendo consigli a ChatGPT su come nascondere il vomito, non può affrontare quel comportamento o educare il paziente sui rischi. Devono essere preparati ad affrontare questa realtà.

Salute mentale e AI

Questo rapporto si aggiunge alle crescenti preoccupazioni sui chatbot e il loro impatto psicologico. Ci sono già state diverse segnalazioni che collegano l’uso dell’AI a episodi maniacali, pensieri deliranti, autolesionismo e suicidi. Aziende come OpenAI hanno ammesso i rischi e stanno affrontando un numero crescente di cause mentre cercano di rafforzare le protezioni.

Ma migliorare non basta quando il problema è strutturale. I chatbot sono fatti per essere sempre disponibili, accondiscendenti, pronti ad aiutare. Caratteristiche che li rendono utili ma anche rischiosi per chi è fragile. E finché le aziende metteranno engagement e soddisfazione dell’utente davanti a tutto, questi problemi non spariranno magicamente.