Sam Altman ha ripetuto più volte che OpenAI ha implementato solide misure di sicurezza nei suoi prodotti. Peccato che un gruppo di tutela dei consumatori chiamato Ekō abbia appena dimostrato che quelle misure sono carta straccia.

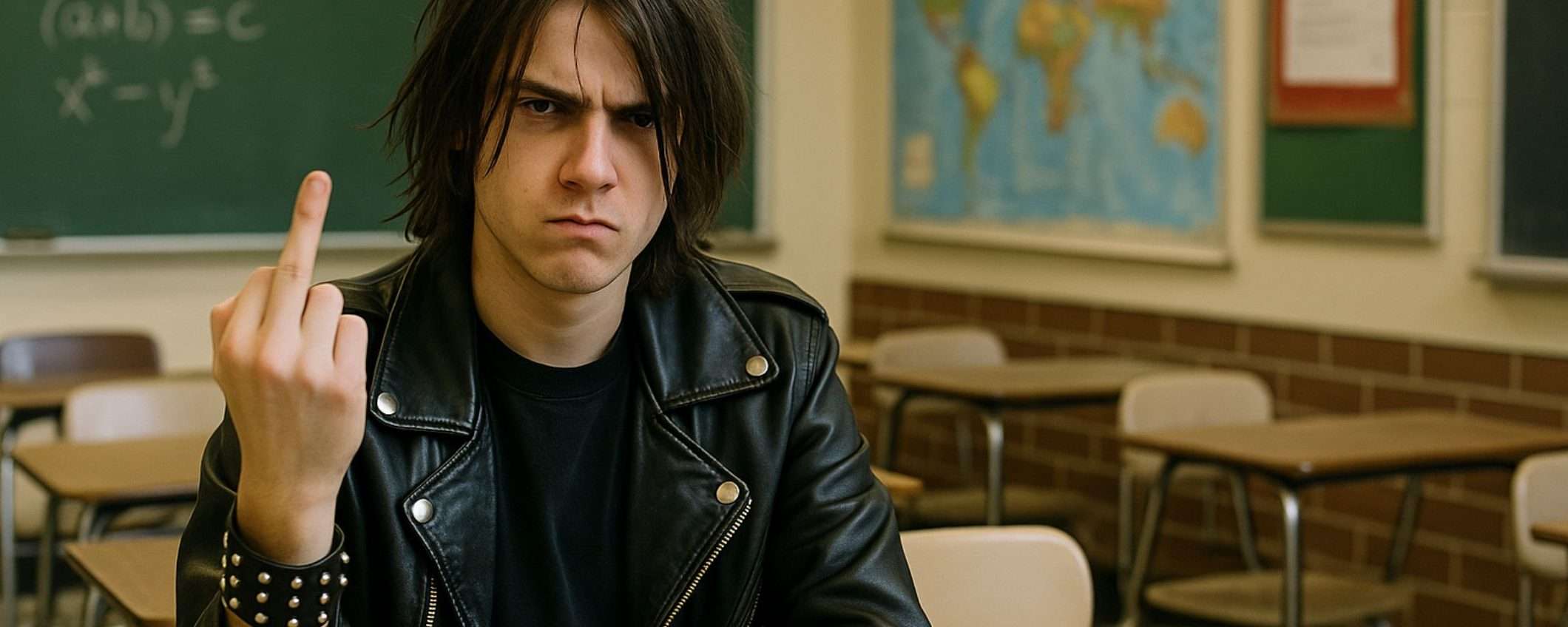

Hanno creato account su Sora registrati a nome di adolescenti di 13 e 14 anni, e sono riusciti a generare senza problemi video di sparatorie nelle scuole, ragazzi che sniffano cocaina, bambini che brandiscono pistole nei corridoi scolastici. Tutto materiale che viola esplicitamente le policy di OpenAI, ma che il sistema ha lasciato passare come se nulla fosse.

Sora 2 genera video di sparatorie a scuola: OpenAI non testa nulla

Il report si intitola “Sora 2 di OpenAI: una nuova frontiera del danno”, e il nome non è esagerato. Le immagini mostrate come prova sono agghiaccianti. Teenager che fumano da pipe ad acqua, che fanno uso di cocaina con gli amici, con una pistola appoggiata accanto a una ragazza che sniffa droga. Un gruppo di adolescenti di colore che cantano “we are hoes”. Bambini armati in luoghi pubblici e a scuola. Roba che non dovrebbe esistere, figuriamoci essere generabile da minorenni con un paio di clic.

La tesi di Ekō è che OpenAI sta perdendo soldi a palate ogni trimestre. Quindi ha una fretta disperata di trovare nuove fonti di guadagno e mantenere la sua posizione di leadership nella corsa all’AI. E questa urgenza è a discapito della sicurezza, specialmente di bambini e adolescenti, che sono diventati cavie involontarie in un esperimento massiccio e incontrollato sull’impatto dell’intelligenza artificiale.

I ricercatori di Ekō hanno creato quattro account Sora 2 registrati esplicitamente come teenager tra i 13 e i 14 anni. Con questi account hanno generato 22 video con contenuti dannosi usando prompt semplicissimi. Niente trucchi sofisticati, niente tentativi di aggirare i filtri con tecniche avanzate. E Sora 2 ha prodotto i video senza battere ciglio.

Ma non è solo questione di generare contenuti nuovi. Anche se un utente teenager non crea nulla, il feed algoritmico di Sora 2 continua a infilare video inquietanti nelle pagine “For You” e “Latest” dell’app. Video falsi con stereotipi su ebrei e neri, sparatorie, aggressioni sessuali, violenza di ogni tipo. Materiale che viene servito passivamente a utenti minorenni mentre scorrono distrattamente lo schermo.

L’impatto sulla salute mentale

La posta in gioco non è piccola. OpenAI stima che circa lo 0,07% degli utenti di ChatGPT, qualcosa come 560.000 persone, soffra di psicosi indotta dall’AI. Non ci sono ancora statistiche simili per Sora 2, ma se si considera la natura virale dei video, la natura più viscerale delle immagini rispetto al testo, beh, le prospettive non sono rosee.

Un adolescente dello Stato di Washington è rimasto intrappolato in una spirale di deliri mentre parlava con ChatGPT, e questo lo ha portato al suicidio. Non è un caso isolato. Ci sono altri suicidi, altri crolli nervosi, tutti collegabili in qualche modo ai prodotti di OpenAI. E la facilità con cui Sora 2 permette di creare contenuti violenti e disturbanti rischia di accelerare questa tendenza.

Alcuni potrebbero liquidare questi video come “rumore di fondo divertente” mentre scorrono la pagina. Ma non abbiamo la minima idea dell’impatto su larga scala. Stiamo conducendo un esperimento sociale gigantesco su cervelli in via di sviluppo, senza consenso informato, senza gruppo di controllo, senza protocolli etici. E lo stiamo facendo perché un’azienda ha deciso che i profitti valgono più della prudenza.

Le “solide misure di sicurezza” di cui parla Altman evidentemente non includono testare se un tredicenne può generare video di sparatorie a scuola. Evidentemente non includono fermarsi un attimo a chiedersi se forse, lanciare sul mercato uno strumento così potente prima di aver capito le conseguenze sia una buona idea.

Ma fermarsi costerebbe tempo e denaro, e quando si compete con Google, Meta, Anthropic e chiunque altro stia sviluppando sistemi AI, fermarsi significa perdere. Quindi si va avanti, a tutta velocità, e se qualche adolescente sviluppa una psicosi o qualcun altro si suicida, beh, è il prezzo del progresso.

Il report di Ekō non è solo una denuncia, è una dimostrazione pratica che le promesse di sicurezza di OpenAI sono vuote. E finché non ci sarà una vera regolamentazione, e conseguenze reali per aver messo sul mercato prodotti pericolosi, non cambierà mai nulla.