Grazie ad un incontro con Marco Pancini, Director Public Policy EMEA di YouTube, è stato possibile approfondire ciò che il servizio video di Google port avanti per combattere la disinformazione in mesi delicati come questi della pandemia. Approfondire il tema, in particolare, consente di aggirare la semplicistica divisione binaria tra video autorizzati e video non autorizzati, andando più nel dettaglio di un processo di analisi molto complesso e delicato.

YouTube: la responsabilità prima di tutto

Pancini è chiaro a tal proposito: “La responsabilità è la nostra priorità numero uno: ce lo chiedono i nostri utenti, i nostri partner, tutti coloro i quali hanno a che fare con la nostra piattaforma“. Una piattaforma deve dunque essere responsabile non soltanto per rispondere alle aspettative delle autorità e per far fronte ad una consapevolezza del proprio ruolo sociale, ma anche per una vera e propria necessità: abdicare al proprio ruolo di controllore significherebbe perdere valore agli occhi di tutti gli stakeholder interessati alla produzione di valore della piattaforma stessa.

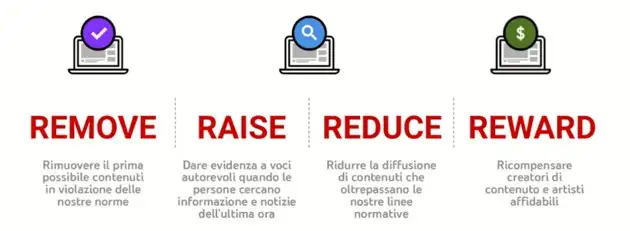

Per far fronte a questo impegno, YouTube fa proprio il manifesto delle “quattro R”:

- Remove

Rimuovere il prima possibile contenuti in violazione delle nostre norme - Raise

Dare evidenza a voci autorevoli quando le persone cercano informazione e notizie dell’ultima ora - Reduce

Ridurre la diffusione di contenuti che oltrepassano le nostre linee normative - Reward

Ricompensare creatori di contenuto e artisti affidabili

Per YouTube avere regole chiare e trasparenti è diventata una necessità assoluta: solo così la piattaforma è in grado di tenere sotto controllo un flusso di upload medio che è ormai arrivato a 500 ore di video caricati ogni singolo minuto che passa.

Far fronte alla propria responsabilità non significa soltanto creare un filtro che sappia identificare taluni video, ma va anche oltre. I limiti relativi alla monetizzazione, ad esempio, sono ancor più stringenti rispetto alle regole che rendono accettabile un contenuto: YouTube non intende foraggiare contenuti non positivi, che non apportano contributi validi alla community, e per questo motivo agendo in ottica di “moral suasion” inibendo la monetizzazione ed evitando di farsi “partner” di possibili malcelate violazioni.

L’impegno in ottica di responsabilità è stato inoltre affrontato attraverso pannelli informativi che compaiono sull’interfaccia per portare gli utenti verso informazioni accurate ed autorevoli, offrendo dunque sempre una alternativa valida rappresentata da contenuti informativi di valore. Questi riquadri hanno raccolto dal lancio oltre 400 miliardi di impression, numero che quantifica concretamente l’impegno di Google per dare maggior risalto alle verità. Chi cerca informazioni su YouTube, insomma, ha sempre e comunque un “link” a disposizione verso contenuti autorevoli e consolidati: sta al singolo utente la scelta della fonte a cui abbeverarsi.

La repository ha inoltre dato priorità alle fonti più autorevoli per veicolare notizie quanto più affidabili possibile, ma anche fatto qualcosa di più: YouTube ha collaborato con vari creator per mettere in contatto il loro pubblico con le autorità sanitarie locali e per ottenere risposte alle loro domande. Viene dunque utilizzato il linguaggio dei creator (veri e propri mediatori e collettori di utenza) per ottenere l’attenzione del pubblico e sfruttare quindi questo contatto per veicolare un messaggio autorevole. Un meccanismo virtuoso, insomma, affinché l’approccio responsabile alla pandemia potesse attingere alle migliori risorse disponibili nei rispettivi campi.

Identificare e gestire la disinformazione

YouTube ha voluto gestire il proprio impegno contro la disinformazione adottando un indice in grado di rendere misurabile l’impatto che le azioni intraprese avrebbero avuto nel tempo. L’indice ideato è il Violative View Rate (VVR), ossia il tasso di visualizzazioni inappropriate. Il VVR misura il tasso di esposizione degli utenti ai contenuti non in linea con le policy del gruppo. Non misura dunque soltanto le rimozioni, ma va ben più a fondo pesando i singoli interventi attraverso un indice di esposizione della community ai contenuti dannosi. Si tratta di un indice che misura il livello di inquinamento del dibattito su YouTube, insomma, il cui andamento in calo (-70%) pesa i virtuosismi dell’impegno di Mountain View con IA e machine learning in questa battaglia contro la disinformazione.

Sono tre le modalità con cui YouTube viene a conoscenza di un contenuto potenzialmente dannoso, i cui contenuti saranno in seguito trattati come da policy interna:

- attraverso la segnalazione degli utenti tramite appositi strumenti disponibili sull’interfaccia

- attraverso trusted flagger o autorità partner

- attraverso il machine learning: gli algoritmi vengono “allenati” dalle segnalazioni di cui ai punti 1 e 2, insegnando al sistema la capacità di trovare nuovi potenziali contenuti dannosi che in seguito un elemento umano prenderà in considerazione per l’eventuale effettiva rimozione

Una volta identificato un contenuto potenzialmente in violazione delle policy, viene vagliato da risorse umane in grado di comprenderne la lingua e di poterne giudicare nel merito i contenuti: in caso di violazione il video viene rimosso dalla repository, lasciando comunque all’autore la possibilità di chiedere una revisione della decisione; in casi dubbi, il responsabile incaricato ha la possibilità di chiedere l’assistenza di altri revisori o addirittura di esperti esterni per approfondire la questione.

I dati conseguenti sono eclatanti: nell’ultimo trimestre, il numero di contenuti eliminati da YouTube a seguito di identificazione tramite machine learning è stato pari al 94% del totale. Dunque a livello statistico ogni 6 contenuti segnalati dall’uomo corrispondono a 94 identificati dalla macchina, il che consegna agli utenti un altissimo potere nell’identificazione dei contenuti deleteri in ambito medico. Fondamentale, inoltre, la velocità: il 75% dei contenuti identificati tramite machine learning sono stati rimossi prima che riuscissero a raggiungere anche solo 10 visualizzazioni. L’impatto sulla community diventa minimo e l’indice VVR è così potuto scendere il modo considerevole nel tempo.

I contenuti sono identificati come contrari alle regole di YouTube quando “includono affermazioni che contraddicono il pensiero degli esperti delle autorità sanitarie mondiali e locali“. Se c’è da tracciare una sottile linea rossa che separi quel che è contemplato da quel che non lo è, questa linea è stabilita dalla scienza. A partire da questo punto fermo, YouTube vieta video che promuovono teoremi no-vax o che scoraggiano all’adozione dei vaccini, inoltre anestetizza la monetizzazione quando il contenuto contraddice l’opinione degli esperti delle autorità sanitarie locali.

Chiaramente ci sono delle eccezioni (EDSA): video – o commenti, o live streaming – in cui è chiaro che si intende portare avanti impegni educativi, documentaristici, scientifici o artistici, restano liberamente disponibili poiché YouTube non vuol certo essere portatore di un fantomatico “pensiero unico”, ma farsi invece profeta di una moltitudine di punti di vista. Purché, soprattutto in fase di pandemia, ciò non favorisca l’insorgere di teoremi complottisti privi di alcun supporto scientifico e al di fuori di ogni perimetro di realtà.

Dall’inizio della pandemia ad oggi sono stati rimossi 850 mila video per violazioni legate all’ambito medico, 30 mila dei quali nel solo quarto trimestre del 2020 e relativi al tema dei vaccini: un lavoro massivo, quindi, che nel tempo ha raccolto risultati eclatanti. In Italia il lavoro è stato compiuto in collaborazione con il Ministero della Salute e partner autorevoli, supporti fondamentali per l’identificazione di contenuti deleteri.

La collaborazione europea

L’UE già in tempi non sospetti aveva creato un canale di dialogo con le piattaforme online attraverso il “Codice di condotta dell’UE sulla disinformazione“. Questo tavolo di lavoro è stato utile dapprima in occasione delle elezioni europee e quindi al deflagrare della pandemia come nuova improvvisa emergenza.

Il decisore ha presentato le proprie aspettative mettendo sul piatto linee guida precise alle quali le piattaforme sono andate adeguandosi: la collaborazione tra piattaforme e autorità (benché ora stiamo emergendo problematiche per Facebook sulla specificità del caso italiano) è stata fondamentale per dirimere le azioni da intraprendere durante i mesi più difficili della pandemia ed è questa la nuova base di lavoro cooperativa su cui le parti stanno continuando a lavorare per fare della lotta alla disinformazione una battaglia collettiva ed onnicomprensiva.