L’addestramento dei modelli di intelligenza artificiale generativa, come GPT-4 e DALL-E 3, viene effettuato attraverso enormi database contenenti testo e immagini provenienti da fonti pubbliche accessibili su Internet. Questo “scraping” viene fortemente criticato da scrittori e artisti, in quanto rappresenta una violazione del copyright. La soluzione proposta dai ricercatori dell’università di Chicago si chiama Nightshade.

Avvelenamento dei dati per ingannare i crawler

Gli autori di libri, brani musicali o immagini artistiche non sono contrari all’uso dell’intelligenza artificiale generativa, ma all’uso non autorizzato delle loro opere per addestrare i modelli. Sono già molte le denunce per violazione di copyright, ma al momento l’unico modo per evitare lo scraping è bloccare i crawler delle aziende (se possibile).

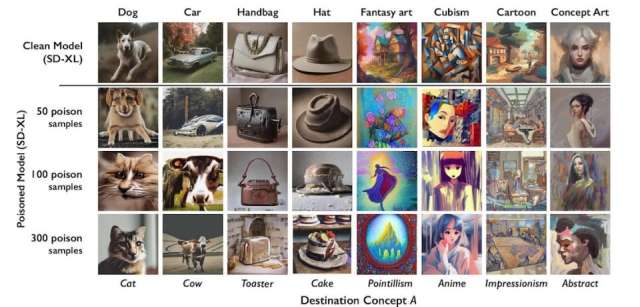

I ricercatori dell’università di Chicago hanno quindi trovato una soluzione più efficace. Il tool Nightshade “avvelena” i dati usati per l’addestramento dei modelli text-to-image, quindi i risultati ottenuti con DALL-E, Stable Diffusion o Midjourney sono inutilizzabili. Se l’utente chiede di generare l’immagine di un cane o di un’automobile, l’output sarà un gatto o una mucca.

Il tool, che sarà open source, permette agli artisti di aggiungere modifiche ai pixel dell’immagine originale (invisibili all’occhio umano) per ingannare i modelli IA. Queste immagini alterate digitalmente verranno aggiunte ai database usati per l’addestramento. Se il loro numero supera una certa soglia, DALL-E, Stable Diffusion o Midjourney genereranno immagini completamente sbagliate.

Per testare il tool è stato utilizzato il modello Stable Diffusion di Stability AI. Bastano 50 immagini “avvelenate” per ottenere risultati di bassa qualità. Con 300 immagini, un cane diventa un gatto, un’automobile diventa una mucca e una borsetta diventa un tostapane.

I ricercatori affermano che Nightshade potrebbe essere usato da malintenzionati, ma il rischio è minimo. Il tool è invece un potente deterrente per le aziende che continuano ad usare opere protette dal diritto d’autore senza chiedere il permesso.