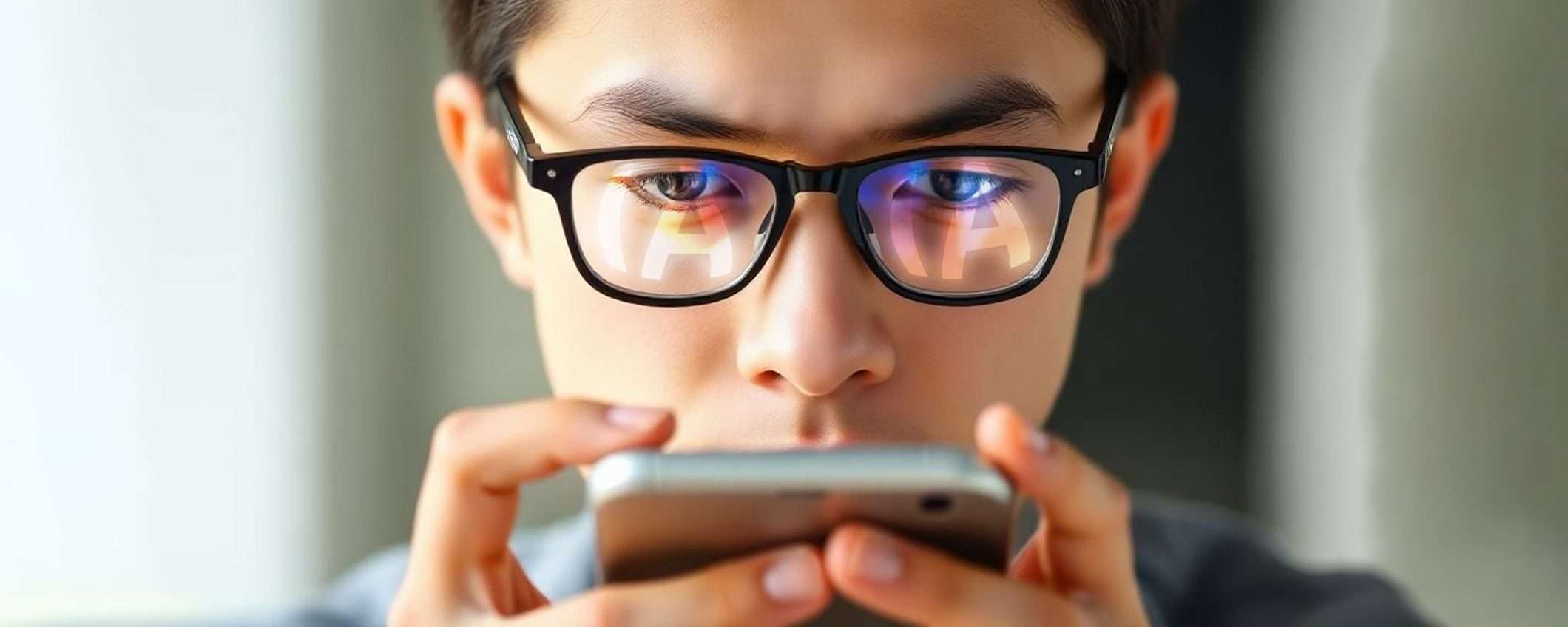

C’è chi preferisce una navigazione vecchio stile, fatta di query inviate ai motori di ricerca, pagine dei risultati da scorrere alla scoperta del link migliore da consultare e URL digitati nella barra dell’indirizzo o da caricare dall’elenco dei preferiti. E poi c’è chi preferisce tagliare corto e accontentarsi di quanto restituito da un riassunto generato dall’intelligenza artificiale. Quest’ultima categoria di utenti è sempre più numerosa e, inevitabilmente, il suo impatto in termini di redditività per l’editoria online si fa sentire.

L’editoria online ai tempi dell’AI

Cambiano i tempi, cambiano le modalità di fruizione. È inevitabile. La grana, per chi spende tempo, risorse e competenze nel mantenere vivo un qualsiasi portale (non necessariamente un sito di informazione), è legata a una dinamica ben precisa e quanto sta accadendo forse si sarebbe potuto evitare o quantomeno gestire meglio.

Realtà come OpenAI con i suoi ChatGPT e Search, ma anche la stessa Google attraverso una funzionalità come AI Overview, estrapolano quanto scritto dagli addetti ai lavori, lasciano che i loro modelli lo fagocitino durante l’addestramento e infine che lo risputino sullo schermo dell’utente finale, senza, o quasi, garantire un ritorno, economico o in termini di traffico, a chi si è occupato di produrlo.

Google, OpenAI e gli altri

Il fenomeno in atto è ben descritto dai numeri appena diffusi da Matthew Prince, CEO di Cloudflare, durante un evento andato in scena a Cannes, in Francia. Dieci anni fa, Google analizzava due pagine Web per ogni visitatore che, passando dal suo motore di ricerca, finiva sul sito di un editore (2:1). Il rapporto è salito a 6:1 sei mesi fa, fino a raggiungere oggi 18:1. La causa è da ricercare proprio in funzionalità già citate come AI Overview.

All’inizio dell’anno, per i servizi di OpenAI la quota era 250:1, ora 1.500:1, mentre per Anthropic si è passati nello stesso periodo da 6.000:1 a 60.000:1.

Ciò che accade è che gli utenti online ignorano completamente o quasi i link alla fonte. Contestualmente, cresce la fiducia negli strumenti di intelligenza artificiale e diminuisce lo stimolo a consultare il contenuto originale, con buona pace di chi lo ha creato, impegnando tempo, risorse e competenze.

Il problema dello scraping indiscriminato

Lo stesso Prince afferma che Cloudflare ha quasi pronta la soluzione al problema: un nuovo tool che promette di impedire ai colossi AI di effettuare lo scraping indiscriminato. Per gli editori sarà sufficiente aderire all’iniziativa.

La sua efficacia è però tutta da verificare, rischia di trasformarsi nel proverbiale recinto chiuso quando i buoi sono già scappati. Il sostanziale gap normativo, ancora oggi, consente alle grandi realtà del settore di appropriarsi (non sempre in modo lecito) di tutto quanto presente online, per addestrare i modelli attraverso i quali proporre poi i loro servizi e monetizzare.

Non è un caso, ad esempio, che BBC abbia appena puntato il dito contro Perplexity per lo sfruttamento non autorizzato dei suoi contenuti. Ed è solo l’esempio più recente. La questione non riguarda esclusivamente gli scritti: la vicenda Ghibli che ha tenuto banco un paio di mesi fa ne è una dimostrazione concreta.