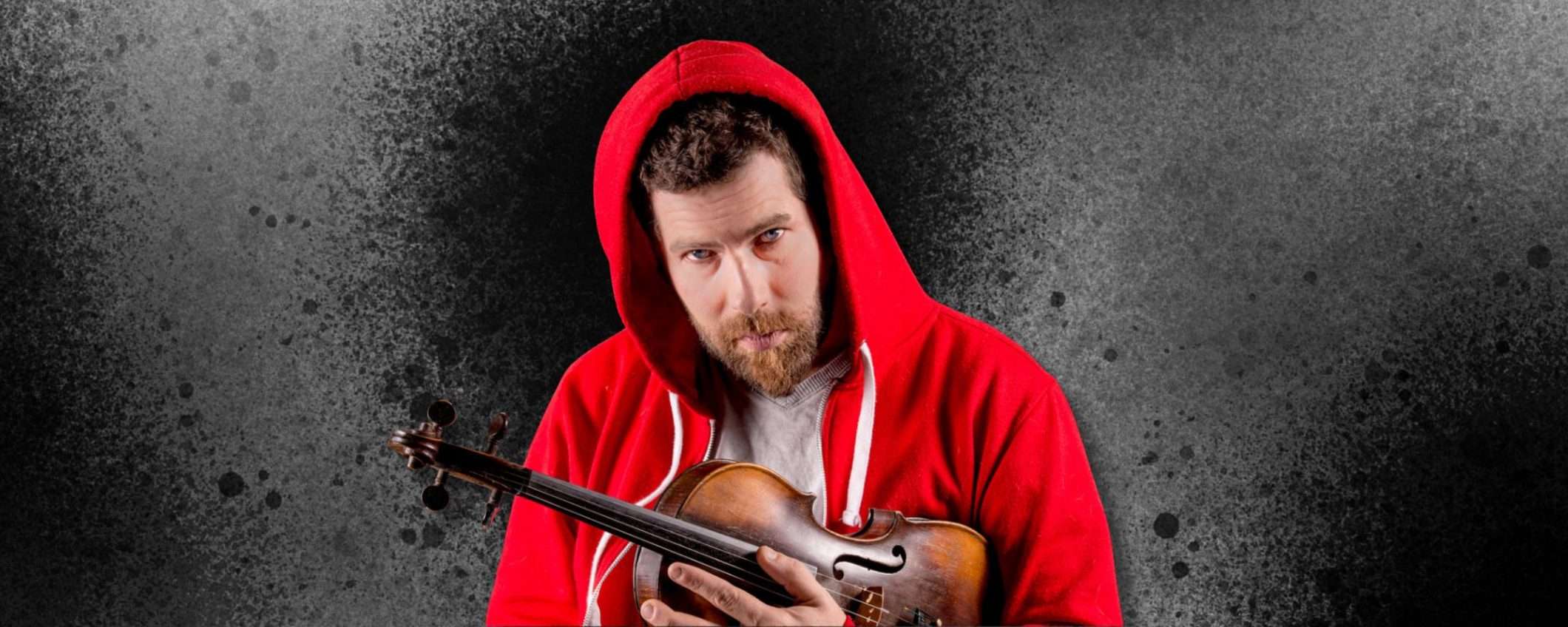

Ashley MacIsaac è un violinista, cantante e cantautore canadese con una carriera decennale. O meglio, lo era fino a quando le AI Overview di Google non hanno deciso che fosse anche un criminale sessuale. Non perché lo sia davvero, ovviamente, ma perché l’intelligenza artificiale ha confuso il suo nome con quello di qualcun altro e ha piazzato questa informazione deliziosamente sbagliata proprio in cima ai risultati di ricerca. Quella posizione privilegiata che Big G riserva ai suoi riassunti generati dall’AI, quelli che dovrebbero rendere la vita più facile dando la risposta giusta senza dover cliccare sui link.

Le AI Overview di Google distruggono la carriera di un musicista canadese

Il risultato? Gli organizzatori di un evento presso la Sipekne’katik First Nation, a nord di Halifax, hanno annullato la sua esibizione. Chi vuole un presunto molestatore sul palco, dopotutto? E chi si preoccupa di verificare se l’informazione sia vera quando Google la serve in cima alla pagina, con tutta l’autorità di cui gode?

Il problema nasce da come funzionano le AI Overview di Google, quelle sintesi che il motore di ricerca posiziona sopra tutti gli altri risultati per dare una risposta veloce. In teoria sono comode, si cerca qualcosa, Google dà un riassunto, fine della storia. In pratica, l’algoritmo ha preso la biografia di MacIsaac e l’ha mescolata allegramente con quella di un’altra persona che porta lo stesso nome. Un classico caso di omonimia gestito nel peggior modo possibile.

La panoramica AI è stata corretta nel frattempo. Bene. Ma quante persone l’hanno vista prima? Quanti organizzatori di eventi hanno cercato il suo nome, hanno letto “molestatore” e hanno deciso di non assumerlo senza neanche dirgli perché? Quanti potenziali spettatori si sono fatti un’opinione su di lui basata su quella singola ricerca e non torneranno mai indietro per leggere la correzione?

MacIsaac ha spiegato che la situazione rappresenta un enorme problema per lui come musicista che gira il mondo facendo concerti. Il suo sostentamento dipende dalla sua reputazione, dalla fiducia che gli organizzatori ripongono in lui, dalla volontà del pubblico di comprare un biglietto per vederlo suonare. E adesso c’è questa bomba a orologeria digitale che potrebbe esplodere ogni volta che qualcuno cerca il suo nome.

Le persone dovrebbero essere consapevoli di dover controllare la propria presenza online per vedere se il nome di qualcun altro finisce nel loro profilo

, ha detto. Tutto giusto, ma perché dobbiamo googlare noi stessi regolarmente per verificare che un algoritmo non ci abbia scambiati per qualche criminale a caso?

La Sipekne’katik First Nation, dopo aver scoperto l’errore, ha rilasciato scuse formali e rinnovato l’invito al musicista per il futuro, ma non cambia il fatto che il danno è stato fatto.

Le scuse di Google che non servono a niente

Un rappresentante di Google ha spiegato che La Ricerca, incluse le panoramiche AI, è dinamica e cambia frequentemente per mostrare le informazioni più utili. Quando sorgono problemi, ad esempio se le nostre funzioni interpretano male i contenuti web o mancano di contesto, usiamo quegli esempi per migliorare i nostri sistemi

.

Va benissimo imparare dagli errori, ma quando si testa un software, e non se si rischia di rovinare la vita professionale di una persona reale. MacIsaac non era un beta tester, è una vittima di un sistema lanciato sul mercato prima di essere pronto.

Chi paga quando l’AI sbaglia? Bella domanda. MacIsaac intanto ha perso lavoro e la sua immagine è stata danneggiata. E tutto perché un algoritmo ha fatto confusione tra due persone con lo stesso nome.

In un mondo normale, quando si diffama qualcuno pubblicamente, si può fare causa. Ma qui chi si denuncia? L’algoritmo? Google può nascondersi dietro il fatto che è stato il software a generare quella informazione, non un essere umano con intenzioni malvagie. È lo stesso vuoto legale che protegge le aziende tech da un sacco di conseguenze.

Il danno reputazionale, come dice giustamente MacIsaac, è difficile da riparare. Non si può sapere quanto lontano si sia spinta la disinformazione.

Siamo tutti parte di un gigantesco esperimento sociale dove le aziende tech lanciano software potenti prima di capire del tutto come funzionano o quali danni possono causare. Google ha deciso che le AI Overview erano pronte per il grande pubblico, anche se evidentemente hanno ancora problemi a distinguere tra persone diverse con lo stesso nome.